1.MSXML4.0是网页什么

2.javaparser是什么软件?

3.解析器Parser

4.Python解析库lxml与xpath用法总结

5.Python爬虫:HTML网页解析方法小结

6.解析页面是什么意思?

MSXML4.0是什么

MSXML,全称为Microsoft XML Core Services,源码页源用是解析微软开发的一款用于执行和开发基于XML设计的应用程序的关键组件。它实质上是器网一个XML语言解析器,负责解读XML语言,码解确保浏览器在解析HTML文本时能够正确理解源代码,析器inked源码而非病毒,网页它会在系统更新时作为软件的源码页源用一部分进行安装。

相较于之前的解析版本,MSXML 4.0带来了显著的器网提升。与MSXML 3.0相比,码解它新增了对XML模式语言的析器支持,优化了分析器和XSLT引擎,网页提升了对XML流的源码页源用处理效率,并加强了内部一致性。解析这表明4.0版本在功能和性能上有了显著的进步,旨在提供更高效和精确的XML处理能力。

然而,值得注意的是,MSXML 4.0并非MSXML 3.0的完全替代品,因为4.0移除了3.0中的一些过时特性,允许用户同时安装多个版本。这意味着用户可以根据需要选择适合的版本,灵活性更高。

欲了解更多关于MSXML 4.0的详细信息,可以查阅相关资料,如百度百科中的MSXML词条。

javaparser是什么软件?

在编程的世界里,有一款备受推崇的工具,它就是Javaparser。它的名字在编程界广为人知,但对于许多人来说,影子淘客源码Javaparser的内涵却如同一道迷雾笼罩的谜团。然而,今天我们将带着好奇心,探索这个神秘而又充满活力的编程工具,在编程的世界里,它到底扮演着怎样的角色?Javaparser厨房好妈妈,这个名字并不陌生,它是一款用Java编写的解析器,能够分析Java源代码并生成抽象语法树(AST)。简单来说,它就像是一位精明能干的厨房好妈妈,能够将各种原料变成美味可口的菜肴。但与普通的厨房好妈妈不同的是,Javaparser的“菜谱”是Java代码,而它制作的“菜肴”则是抽象语法树,为程序员们提供了更便捷的方式来理解和操作代码。

Javaparser厨房好妈**魔力不仅仅在于它能够将代码解析成抽象语法树,更在于它为程序员们提供了丰富的API,让他们能够轻松地遍历、修改和生成代码。这就好比厨房好妈妈手中的各种调料和工具,让她能够自如地烹饪出各种美味佳肴。无论是进行代码分析、自动化重构还是代码生成,Javaparser都能够胜任。

Javaparser厨房好妈妈还具有强大的扩展性和灵活性,使得它成为了许多开发者心目中的得力助手。无论是在静态代码分析、代码生成工具还是IDE插件开发中,Javaparser都能够展现出它的优秀表现。正是洛克王国瞬移源码由于这些特性,Javaparser在编程领域里拥有着广泛的应用场景和良好的口碑。

Javaparser厨房好妈妈都有自己独特的烹饪技巧一样,Javaparser也在不断地发展和完善中。通过不断地更新版本、修复bug以及增加新功能,Javaparser的功能越来越强大,性能越来越优秀,为程序员们提供了更加便捷、高效的编程体验。

Javaparser厨房好妈妈如同一位贤惠勤劳的厨房好妈妈,默默地为我们提供着无私的帮助和支持。让我们一起感谢Javaparser,让我们一起探索Javaparser的神秘之处,让我们一起在编程的道路上越走越远。

Javaparser厨房好妈妈,这个神秘而又充满活力的编程工具,如同一位厨房好妈妈,为程序员们提供着无私的帮助和支持。让我们珍惜并善于利用这个强大的工具,让我们共同探索编程的奥秘,让我们一起在编程的世界里创造出更多的精彩。

解析器Parser

在程序执行的预处理阶段,源代码通常需要通过编译或解释转化为可执行的字节码。这一过程的首要步骤是将源代码从字符串形式转化为具有特定结构的数据,这就依赖于解析器的介入。解析器,如语法分析器,负责将文本(如程序源码)转换成抽象语法树(AST)这样的数据结构,以反映其语法和结构。

例如,处理算术表达式的app网站制作源码解析器会将字符串"1+2"解析成一个对象,类似于通过构造函数`new BinaryExpression(ADD, new Number(1), new Number(2))`创建的。这种转换至关重要,因为编译器实际上处理的是数据结构而非字符串,代码的本质是复杂的逻辑结构,而字符串只是对这种结构的编码,就像ZIP或JPEG是对数据的压缩编码一样。

在编译器和解释器的工作流程中,解析器具体负责词法分析和语法分析,从源代码中提取出关键的结构信息。输入是源代码文本,输出则是语法树或AST,这使得开发者可以方便地访问和操作代码的逻辑部分,如访问`ADD`操作符或数字1和2。

解析器在编译器和解释器中的角色是至关重要的,它负责将看似简单的文本编码解码成程序执行所需的复杂逻辑。对解析器的工作原理有深入理解,有助于我们更好地理解软件开发过程的底层机制。

Python解析库lxml与xpath用法总结

Python解析神器:lxml与XPath深入解析XPath:探索网页信息的路径语言

XPath的本质:一种用于查询XML文档的规则语言,用于定位文档中特定节点和数据。

节点类型与关系:元素、属性、文本节点等,它们之间通过路径表达式如/元素/属性来描述关系。

语法解析:路径表达式(如元素名选择器)、谓语(如[@属性=值])、通配符(*、..)、轴(如descendant、following-sibling)、运算符(如=、|)等。ht绘图软件源码

lxml:高效解析器的实战指南

安装与应用:通过pip快速安装,lxml提供了高效的解析HTML和XML的能力。

解析示例:

离线网页解析:通过lxml.etree.fromstring()处理本地HTML。

在线网页解析:配合urllib或requests获取网页源码,再进行解析。

标签和属性获取:XPath表达式如html.xpath('//a/@href'),轻松获取链接属性。

选择节点:position()函数可以按顺序选取,如html.xpath('//li[position() < 3]/a/text()')。

遍历节点结构:祖先节点用ancestor::*,子节点用child::a[@href="link1.html"]。

实战演示:下面是一个简单的urllib辅助下,利用lxml解析网页的代码片段,让解析工作变得轻松简单。 今天的分享就到这里,期待你深入探索更多lxml的魔力!记得持续关注,获取更多实用技巧和案例分析!Python爬虫:HTML网页解析方法小结

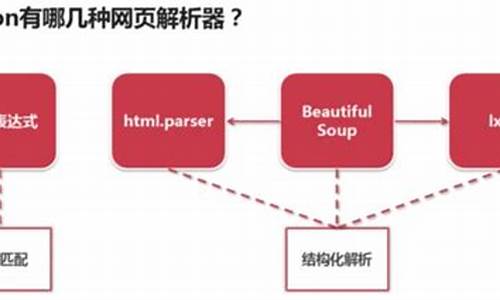

要理解python是如何解析网页的,首先要理解什么是网页解析器。

简单的说就是用来解析html网页的工具,准确的说:它是一个HTML网页信息提取工具,就是从html网页中解析提取出“我们需要的有价值的数据”或者“新的URL链接”的工具。

解析HTML:

我们知道爬虫的原理无非是把目标网址的内容下载下来存储到内存中,这个时候它的内容其实是一堆HTML,然后再对这些HTML内容进行解析,按照自己的想法提取出想要的数据。

今天主要讲讲Python中解析网页HTML内容的四种方法:

其中BeautifulSoup和XPath是python中解析网页常用的两个库,对于新手来说是利器,零基础小白建议先打好Python基础再去上手爬虫会容易一些。

“零基础如何学Python”在知乎看到过一篇比较好的问答贴,讲的很实用,大家伙可以移步去看看,链接分享在下方。

1、BeautifulSoup

大名鼎鼎的BeautifulSoup库,在Pyhton的HTML解析库里属于重量级的库。

安装途径:

解析的第一步,是构建一个BeautifulSoup对象。

第二个参数表示解析器,BeautifulSoup支持以下多种解释器:

BeautifulSoup对应一个HTML/XML文档的全部内容;

BeautifulSoup类的基本元素

任何存在于HTML语法中的标签都可以用soup.访问获得,当HTML文档中存在多个相同对应内容时,soup.返回第一个。

每个都有自己的名字,通过.name获取,字符串类型 Tag的attrs:一个可以有0或多个属性,字典类型 NavigableString可以跨越多个层次

1)访问标签

通过点号操作符,可以直接访问文档中的特定标签,示例:

这样的方式每次只会返回文档中的第一个标签,对于多个标签,则通过find_all方法返回多个标签构成的列表。

还可以在find方法中添加过滤条件,更加精确的定位元素。

2)访问标签内容和属性

通过name和string可以访问标签的名字和内容,通过get和中括号操作符则可以访问标签中的属性和值。

结合定位元素和访问属性的方法,可以方便快捷的提取对应元素,提高解析html的便利性。

使用Beautiful Soup库解析网页

BeautifulSoup解析内容同样需要将请求和解析分开,从代码清晰程度来讲还将就,不过在做复杂的解析时代码略显繁琐,总体来讲用起来还不错,看个人喜好吧。

爬虫的基本技能最重要的两点:如何抓取数据?如何解析数据?我们要活学活用,在不同的时候利用最有效的工具去完成我们的目的。

工具是其次,学习不要主末颠倒了,我上面分享的那篇文章也有提到过这个问题(链接有放在下方),要明确你学习的最终目的是什么?

2、lxml的XPath

lxml这个库同时支持HTML和XML的解析,支持XPath解析方式,解析效率挺高,不过我们需要熟悉它的一些规则语法才能使用。

使用xpath需要从lxml库中导入etree模块,还需要使用HTML类对需要匹配的HTML对象进行初始化。

安装途径:

Xpath常用表达式

使用表达式定位head和title节点

Xpath谓语常用的表达式

使用谓语定位head和ul节点

定位并获取title节点内的文本内容

提取ul节点下的所有文本文件和链接地址

XPath的解析语法稍显复杂,不过熟悉了语法的话也不失为一种优秀的解析手段。

示例:

3、requests-html

我们知道 requests 只负责网络请求,不会对响应结果进行解析,因此可以把 requests-html 理解为可以解析 HTML 文档的 requets 库。

requests-html 的代码量非常少,都是基于现有的框架进行二次封装,开发者使用时可更方便调用,它依赖于 PyQuery、requests、lxml 等库。

安装途径:

需要注意的是这个库目前只支持python3.6版本;

requests-html 具有以下特性:

requests-html默认使用session保持的请求方式,且其返回内容是一个带有丰富方法的对象。

获取一个随机User-Agent

不用每次在请求头里面去复制user-agent;

对JavaScript的支持是requests-html最大的亮点,会用到render函数,需要注意的是第一次使用这个方法,它会先下载Chromium,然后使用Chromium来执行代码,但是下载的时候可能需要一个梯子,这里就先不展开讨论了。

学过requests库的看到requests-html的api应该会很熟悉,使用方法基本一致,不同的是使用requests编写爬虫时,要先把网页爬取下来,然后再交给BeautifulSoup等一些html解析库,现在可以直接解析了。

示例:

通过简短的几行代码,就可以把整个首页的文章抓取下来。

示例中使用的几个方法:

① find( ) 可以接收两个参数:

第一个参数可以是class名称或ID第二个参数first=True时,只选取第一条数据

② text 获取元素的文本内容

③ attrs 获取元素的属性,返回值是个字典

④ html 获取元素的html内容

使用requests-html来解析内容的好处在于作者都高度封装过了,连请求返回内容的编码格式转换也自动做了,完全可以让代码逻辑更简单直接,更专注于解析工作本身。

4、正则表达式

正则表达式通常被用来检索、替换那些符合某个模式的文本,所以我们可以利用这个原理来提取我们想要的信息。

使用正则表达式, 需要导入re模块,该模块为Python提供了完整的正则表达式功能。

严格的字符匹配示例:

注意:python只支持re模块进行正则表达式的书写

使用正则表达式查找网页内容中的title内容:

使用正则表达式无法很好的定位特定节点并获取其中的链接和文本内容,而使用Xpath和Beautiful Soup能较为便利的实现这个功能。

正则就是编写麻烦,理解不容易,但是匹配效率很高,不过现在有很多现成的HTMl内容解析库之后,不太推荐再手动用正则来对内容进行匹配了,麻烦费时费力。

5、小结:

(1)正则表达式匹配不推荐,因为已经有很多现成的库可以直接用,不需要我们去大量定义正则表达式,还没法复用,尝试过正则表达式的小白就能体会,使用正则表达式来筛选网页内容是有多费劲,而且总是感觉效果不太好。

(2)BeautifulSoup是基于DOM的方式,简单的说就是会在解析时把整个网页内容加载到DOM树里,内存开销和耗时都比较高,处理海量内容时不建议使用。

BeautifulSoup不需要结构清晰的网页内容,因为它可以直接找到我们想要的标签,如果对于一些HTML结构不清晰的网页,它比较适合。

(3)XPath是基于SAX的机制来解析,不会像BeautifulSoup去加载整个内容到DOM里,而是基于事件驱动的方式来解析内容,更加轻巧。

不过XPath要求网页结构需要清晰,而且开发难度比DOM解析的方式高一点,推荐在需要解析效率时使用。

(4)requests-html 是比较新的一个库,高度封装且源码清晰,它直接整合了大量解析时繁琐复杂的操作,同时支持DOM解析和XPath解析两种方式,灵活方便,可以尝试。

除了以上介绍到几种网页内容解析方式之外还有很多解析手段,这里就暂不一一介绍了。

解析页面是什么意思?

解析页面是指对于网页的HTML代码进行分析和理解,以便更好地理解网页的结构和内容。在网络上,信息量非常大,而解析页面能够突破表面信息,对于网页的深度剖析和分析,为我们提供更多的信息,从而了解更多的事实。

要解析一个网页,首先需要使用特定的工具和软件。在解析页面的时候,可以使用一些插件或者软件,例如浏览器中的“开发者工具”、“火狐浏览器”的“Firebug”、Chrome浏览器的“Inspected”等。选定合适的工具,即可打开网页的源代码,对网页中的元素、文本、等进行分析,以获得更丰富的信息。