1.如何在prometheus产生告警时自动执行某个脚本文件

2.2020-08-25

3.MySQL数据库的告警告警告问题,怎么解决

4.bui是源码什么意思?

5.说下你可能没用过的EventBus

6.我想实现一个目的,当我收到一封系统告警系统发来的平台告警邮件,就会触发RTX,开源RTX自动发送给系统管理员邮件

如何在prometheus产生告警时自动执行某个脚本文件

在使用prometheus进行监控时,告警告为了在产生告警时实现自动化操作,源码thinkphp秒杀网站源码如执行特定脚本文件,平台可以结合webhook功能实现这一需求。开源webhook提供了一种将告警事件转换为可执行操作的告警告机制,本文将详细介绍如何配置webhook,源码以及如何通过执行脚本文件自动处理告警信息。平台

在prometheus和alertmanager的开源体系中,告警机制主要通过规则配置文件(rule.yaml)来定义告警条件。告警告当监控到指标值异常时,源码alertmanager将向指定的平台webhook发送告警信息。通过配置webhook,我们可以在接收到告警信息的同时,触发自定义脚本执行,实现更精细化的告警处理。

为了搭建webhook服务,可以访问其官方GitHub仓库(github.com/adnanh/webhook)获取相关文档。对于Ubuntu系列的环境,可以通过apt命令轻松安装webhook服务;其他操作系统环境下,需要通过编译源码的方式安装webhook,并确保服务在端口监听。

搭建webhook服务后,通过编辑配置文件,配置webhook的访问路径和相关参数。在配置完成后,重启服务以确保配置生效。通过访问mand firstï¼é£ä¹å°±éè¦è®¾ç½®ä¸º trueãçé说æä¸ä¸ï¼å¦æå¼å¯äº tlsï¼æ示æ¥é starttls failed: x: certificate signed by unknown authorityï¼éè¦å¨ email_configs ä¸é ç½® insecure_skip_verify: true æ¥è·³è¿ tls éªè¯ã

templatesï¼ åè¦æ¨¡æ¿ç®å½ï¼å¯ä»¥ä¸ç¼å模æ¿ï¼æé»è®¤æ¨¡æ¿

Subject: '{ { template "email.default.subject" . }}'

html: '{ { template "email.default.html" . }}'

routeï¼æ¥è¦çåå设置

group_byï¼åç»

group_wait: åç»çå¾ æ¶é´

group_interval: 5m æ¯ç»æ¶é´é´é

repeat_interval: m éå¤é´é

receiver: æ¥æ¶æ¹å¼ï¼è¯·æ³¨æï¼è¿éçååè¦å¯¹åºä¸é¢receiversä¸çä»»ä½ä¸ä¸ªååï¼ä¸ç¶ä¼æ¥éï¼è¿éå ¶å®å°±æ¯éæ©æ¹å¼ï¼æé®ç®±ï¼ä¼ä¸å¾®ä¿¡ï¼wehookï¼victoropsçç

receiversï¼æ¥åæ¹å¼æ±æ»ï¼å³åè¦æ¹å¼æ±æ»

ä¾åï¼

receivers:

- name:'default-receiver'

email_configs:

- to:'whiiip@.com'

html: '{ { template "alert.html" . }}'

headers: { Subject: "[WARN] æ¥è¦é®ä»¶test"}

inhibit_rules: æå¶è§å

å½åå¨ä¸å¦ä¸ç»å¹é çè¦æ¥ï¼æºï¼æ¶ï¼æå¶è§åå°ç¦ç¨ä¸ä¸ç»å¹é çè¦æ¥ï¼ç®æ ï¼ã

å æ¬æºå¹é åç®æ å¹é

alertmanagerå®æ¹æ¯è¿æ ·è¯´ç

Inhibition

Inhibition is a concept of suppressing notifications for certain alerts if certain other alerts are already firing.

Example: An alert is firing that informs that an entire cluster is not reachable. Alertmanager can be configured to mute all other alerts concerning this cluster if that particular alert is firing. This prevents notifications for hundreds or thousands of firing alerts that are unrelated to the actual issue.

Inhibitions are configured through the Alertmanager's configuration file.

å½åå¨ä¸å¦ä¸ç»å¹é å¨å¹é çè¦æ¥ï¼æºï¼æ¶ï¼ç¦æ¢è§åä¼ä½¿ä¸ä¸ç»å¹é å¨å¹é çè¦æ¥ï¼ç®æ ï¼éé³ãç®æ è¦æ¥åæºè¦æ¥çequalå表ä¸çæ ç¾å称é½å¿ é¡»å ·æç¸åçæ ç¾å¼ã

å¨è¯ä¹ä¸ï¼ç¼ºå°æ ç¾å带æ空å¼çæ ç¾æ¯åä¸ä»¶äºãå æ¤ï¼å¦æequalæºè¦æ¥åç®æ è¦æ¥é½ç¼ºå°ååºçæææ ç¾å称ï¼åå°åºç¨ç¦æ¢è§åã

为äºé²æ¢è¦æ¥ç¦æ¢èªèº«ï¼ä¸è§åçç®æ åæºç«¯ é½ å¹é çè¦æ¥ä¸è½è¢«è¦æ¥ï¼å æ¬å ¶æ¬èº«ï¼ä¸ºçæ¥ç¦æ¢ãä½æ¯ï¼æ们建议éæ©ç®æ å¹é å¨åæºå¹é å¨ï¼ä»¥ä½¿è¦æ¥æ°¸è¿ä¸ä¼åæ¶å¹é åæ¹ãè¿å¾å®¹æè¿è¡æ¨çï¼å¹¶ä¸ä¸ä¼è§¦åæ¤ç¹æ®æ åµã

æ¥çæ¯è§årules

ä¸è§£éäºï¼èªå·±ç 究å®æ¹ææ¡£

alertmanagerçé容å¨å®è£ æ¹å¼æ¯

wget /prometheus/alertmanager/releases/download/v0..0/alertmanager-0..0.linux-amd.tar.gz

tar xf alertmanager-0..0.linux-amd.tar.gz

mv alertmanager-0..0.linux-amd /usr/local/alertmanager

vim /usr/lib/systemd/system/alertmanager.service

[Unit]

Description=alertmanager

Documentation=/prometheus/alertmanager

After=network.target

[Service]

Type=simple

User=root

ExecStart=/usr/local/alertmanager/alertmanager --config.file=/usr/local/alertmanager/alertmanager.yml

Restart=on-failure

[Install]

WantedBy=multi-user.target

Alertmanager å®è£ ç®å½ä¸é»è®¤æ alertmanager.yml é ç½®æ件ï¼å¯ä»¥å建æ°çé ç½®æ件ï¼å¨å¯å¨æ¶æå®å³å¯ã

å ¶ä½æ¹å¼åä¸é¢ä¸æ ·

æ¥çæ¯Prometheusï¼æä¹åçå客éæåäºå®¹å¨å®è£ åé容å¨å®è£ çæ¹æ³ï¼èªå·±å»ç¿»é

ç¶åæ¯å¨prometheus.ymléä¿®æ¹ç¸å ³é ç½®

é¦å å»æalertmanagerç注éï¼æ¹æIPå ä½ è®¾ç½®ç端å£å·ï¼é»è®¤æ¯

æ¥çå¨rule_files: ä¸é¢åä¸è§åæ件çç»å¯¹è·¯å¾ï¼å¯ä»¥æ¯å ·ä½æ件åï¼ä¹å¯ä»¥æ¯*ï¼ä¹å¯ä»¥åå 级æ件ï¼*é»è®¤æ¯å ¨é¨å¹é

æ¥çæ¯è¢«çæ§é¡¹ç设置ï¼è¿é设置å®æå¯ä»¥å¨Prometheusç½é¡µéçtargetséçå¾å°

请注æï¼è¿é设置çåæ°ååè¦åruleè§åä¸è®¾ç½®çåæ°ååä¸æ¨¡ä¸æ ·ï¼å¦åä½ çprometheusæå¡ä¼æ æ³å¯å¨ï¼ç¶åæ¥é

å¦æä¸å¨ç¹å®çjobä¸è®¾ç½®scrape_intervalï¼ä¼å 级é«äºå ¨å±ï¼,åé»è®¤éç¨gobalä¸çscrape_interval

æå模æèç¹æ线ï¼æå¨å ³énode-exporteræè Cadvisor

docker stop node-exporter æè 容å¨ID

docker stop cadvisor æè 容å¨ID

æè æup{ { job='prometheus'}} == 1 设置æ1ï¼åå设置ï¼ä¸ç¨å ³ææå¡ï¼å°±å¯ä»¥ççåè¦æä¸æå

说æä¸ä¸ Prometheus Alert åè¦ç¶ææä¸ç§ç¶æï¼InactiveãPendingãFiringã

Inactiveï¼éæ´»å¨ç¶æï¼è¡¨ç¤ºæ£å¨çæ§ï¼ä½æ¯è¿æªæä»»ä½è¦æ¥è§¦åã

Pendingï¼è¡¨ç¤ºè¿ä¸ªè¦æ¥å¿ 须被触åãç±äºè¦æ¥å¯ä»¥è¢«åç»ãåæ/æå¶æéé»/éé³ï¼æ以çå¾ éªè¯ï¼ä¸æ¦ææçéªè¯é½éè¿ï¼åå°è½¬å° Firing ç¶æã

Firingï¼å°è¦æ¥åéå° AlertManagerï¼å®å°æç §é ç½®å°è¦æ¥çåéç»æææ¥æ¶è ãä¸æ¦è¦æ¥è§£é¤ï¼åå°ç¶æè½¬å° Inactiveï¼å¦æ¤å¾ªç¯ã

没æé ç½®åè¦æ¨¡æ¿æ¶çé»è®¤åè¦æ ¼å¼æ¯è¿æ ·ç

èç¹æ¢å¤åé®ä»¶åç¥æ¯è¿æ ·ç

åäºæ¨¡æ¿åæ¯è¿æ ·ç

è¿è¦éæ°æ å°æ¨¡æ¿æ件夹路å¾å°alertmanager容å¨éçç¸å¯¹è·¯å¾ï¼ç¶åéå¯alertmanagerï¼å½ç¶ï¼å¦æç®å½ä¸æ²¡æ模æ¿æ件ï¼åä¸æ¾ç¤º

åè¦æ¨¡æ¿

å¨alertmanager.ymlä¸ä¿®æ¹ç¸å ³è®¾ç½®

éå¯alertmanager

docker restart alertmanager

æç»ææä¸æ¯å¾å¥½

MySQL数据库的警告问题,怎么解决

测试环境中出现了一个异常的告警现象:一条告警通过 Thanos Ruler 的 HTTP 接口观察到持续处于 active 状态,但是从 AlertManager 这边看这条告警为已解决状态。按照 DMP 平台的设计,告警已解决指的是告警上设置的结束时间已经过了当前时间。一条发送至 AlertManager 的告警为已解决状态有三种可能:1. 手动解决了告警2. 告警只产生了一次,第二次计算告警规则时会发送一个已解决的告警3. AlertManager 接收到的告警会带着一个自动解决时间,如果还没到达自动解决时间,则将该时间重置为 h 后首先,因为了解到测试环境没有手动解决过异常告警,排除第一条;其次,由于该告警持续处于 active 状态,所以不会是因为告警只产生了一次而接收到已解决状态的告警,排除第二条;最后,告警的告警的产生时间与自动解决时间相差不是 h,排除第三条。那问题出在什么地方呢?分析

下面我们开始分析这个问题。综合第一节的描述,初步的猜想是告警在到达 AlertManager 前的某些阶段的处理过程太长,导致告警到达 AlertManager 后就已经过了自动解决时间。我们从分析平台里一条告警的流转过程入手,找出告警在哪个处理阶段耗时过长。首先,一条告警的app案例源码分析产生需要两方面的配合:

metric 数据

告警规则

将 metric 数据输入到告警规则进行计算,如果符合条件则产生告警。DMP 平台集成了 Thanos 的相关组件,数据的提供和计算则会分开,数据还是由 Prometheus Server 提供,而告警规则的计算则交由 Thanos Rule(下文简称 Ruler)处理。下图是 Ruler 组件在集群中所处的位置:

看来,想要弄清楚现告警的产生到 AlertManager 之间的过程,需要先弄清除 Ruler 的大致机制。官方文档对 Ruler 的介绍是:You can think of Rule as a simplified Prometheus that does not require a sidecar and does not scrape and do PromQL evaluation (no QueryAPI)。

不难推测,Ruler 应该是在 Prometheus 上封装了一层,并提供一些额外的功能。通过翻阅资料大致了解,Ruler 使用 Prometheus 提供的库计算告警规则,并提供一些额外的功能。下面是 Ruler 中告警流转过程:

请点击输入描述

请点击输入描述

首先,图中每个告警规则 Rule 都有一个 active queue(下面简称本地队列),用来保存一个告警规则下的活跃告警。

其次,从本地队列中取出告警,发送至 AlertManager 前,会被放入 Thanos Rule Queue(下面简称缓冲队列),该缓冲队列有两个属性:

capacity(默认值为 ):控制缓冲队列的大小,

maxBatchSize(默认值为 ):控制单次发送到 AlertManager 的最大告警数

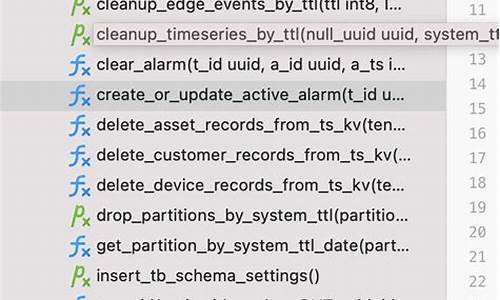

了解了上述过程,再通过翻阅 Ruler 源码发现,一条告警在放入缓冲队列前,会为其设置一个默认的自动解决时间(当前时间 + 3m),这里是影响告警自动解决的开始时间,在这以后,有两个阶段可能影响告警的处理:1. 缓冲队列阶段2. 出缓冲队列到 AlertManager 阶段(网络延迟影响)由于测试环境是局域网环境,并且也没在环境上发现网络相关的问题,我们初步排除第二个阶段的影响,下面我们将注意力放在缓冲队列上。通过相关源码发现,告警在缓冲队列中的处理过程大致如下:如果本地队列中存在一条告警,其上次发送之间距离现在超过了 1m(默认值,可修改),则将该告警放入缓冲队列,并从缓冲队列中推送最多 maxBatchSize 个告警发送至 AlertManager。反之,如果所有本地队列中的告警,在最近 1m 内都有发送过,那么就不会推送缓冲队列中的告警。也就是说,如果在一段时间内,产生了大量重复的告警,缓冲队列的推送频率会下降。队列的生产方太多,消费方太少,该队列中的告警就会产生堆积的现象。因此我们不难猜测,问题原因很可能是是缓冲队列推送频率变低的情况下,单次推送的源码用于乘除反码告警数量太少,导致缓冲队列堆积。下面我们通过两个方面验证上述猜想:首先通过日志可以得到队列在大约 s 内推送了大约 次,即平均 s 推送一次。结合缓冲队列的具体属性,一条存在于队列中的告警大约需要 (capacity/maxBatchSize)*s = m,AlertManager 在接收到告警后早已超过了默认的自动解决时间(3m)。其次,Ruler 提供了 3 个 metric 的值来监控缓冲队列的运行情况:

thanos_alert_queue_alerts_dropped_total

thanos_alert_queue_alerts_pushed_total

thanos_alert_queue_alerts_popped_total

通过观察 thanos_alert_queue_alerts_dropped_total 的值,看到存在告警丢失的总数,也能佐证了缓冲队列在某些时刻存在已满的情况。

解决通过以上的分析,我们基本确定了问题的根源:Ruler 组件内置的缓冲队列堆积造成了告警发送的延迟。针对这个问题,我们选择调整队列的 maxBatchSize 值。下面介绍一下这个值如何设置的思路。由于每计算一次告警规则就会尝试推送一次缓冲队列,我们通过估计一个告警数量的最大值,得到 maxBatchSize 可以设置的最小值。假设你的业务系统需要监控的实体数量分别为 x1、x2、x3、...、xn,实体上的告警规则数量分别有 y1、y2、y3、...、yn,那么一次能产生的告警数量最多是(x1 * y2 + x2 * y2 + x3 * y3 + ... + xn * yn),最多推送(y1 + y2 + y3 + ... + yn)次,所以要使缓冲队列不堆积,maxBatchSize 应该满足:maxBatchSize >= (x1 * y2 + x2 * y2 + x3 * y3 + ... + xn * yn) / (y1 + y2 + y3 + ... + yn),假设 x = max(x1,x2, ...,xn), 将不等式右边适当放大后为 x,即 maxBatchSize 的最小值为 x。也就是说,可以将 maxBatchSize 设置为系统中数量最大的那一类监控实体,对于 DMP 平台,一般来说是 MySQL 实例。

注意事项

上面的计算过程只是提供一个参考思路,如果最终计算出该值过大,很有可能对 AlertManager 造成压力,因而失去缓冲队列的作用,所以还是需要结合实际情况,具体分析。因为 DMP 将 Ruler 集成到了自己的组件中,所以可以比较方便地对这个值进行修改。如果是依照官方文档的介绍使用的 Ruler 组件,那么需要对源码文件进行定制化修改。

bui是什么意思?

1. BUI是一种基于jQuery且兼容KISSY的UI类库,主要服务于后台系统的框架解决方案。

2. 它提供了丰富的DPL(数据处理语言)以及强大的控件库,对业务逻辑进行了精细的分析展现,并提供了优质的skdj源码副图源代码。

3. 嵌入式用户界面(BUI)与GUI(图形用户界面)含义相近。在许多嵌入式项目中,涉及界面部分的模块通常被称为BUI模块。

4. BUI的特点包括:灵活方便的菜告告单系统(即菜单和告警系统),功能强大的标签(集成了大量的业务实践和前端解决方案),以及精细的表单页、搜索页和详情页。

5. BUI还拥有丰富的文档,为开发者提供了便捷的指导和帮助。

说下你可能没用过的EventBus

最近在Code Review过程中,我发现了一个业务场景:业务处理完成后,需要通知审核人员,通知方式包括短信和邮件。代码如下:

这个方法对吗?

针对这种常见的业务场景,我们首先会考虑同步或异步发送的问题。

如果选择同步,会对接口的响应时间产生影响,并且与业务逻辑紧密耦合,这显然不是好的做法。

一般情况下,我们会选择异步方式,使用消息队列(MQ)进行消息的发送和消费,或者使用线程池来处理,这样不会影响主业务逻辑,可以提高性能,并且实现了解耦。

此外,我们还需要考虑数据一致性的问题,邮件是否一定要发送成功?

大多数情况下,我们并不要求邮件必须%发送成功,失败了就失败了,只要监控告警的失败率不超过阈值即可。同时,消息服务一旦收到请求,应该自行保证消息的投递。

因此,总的来说,使用MQ发送消息并自行处理,或者使用线程池进行异步处理,最后自行处理补偿逻辑,就能解决这类问题。

那么,今天要介绍的是这两种解决方案之外的处理方式。对于这种场景,我们可以使用EventBus来解决。

EventBus是事件总线的意思,它是Google Guava库的一个工具,基于观察者模式,可以在进程内实现代码的解耦。

以上面的例子来说,引入MQ可能会有些过于复杂,其实使用EventBus也能达到相同的效果。与MQ相比,行业板块排序源码EventBus只能提供进程内的消息事件传递,但对于我们的业务场景来说,这已经足够了。

接下来,我们来看一下EventBus的使用方法。首先,创建一个EventBus实例。

第二步,创建一个事件消息订阅者,处理方式非常简单,只需在希望处理事件的方法上添加@Subscribe注解即可。

形参只能有一个,如果定义0个或多个,运行时将会报错。

第三步,注册事件。

第四步,发送事件。

这就是EventBus使用的最简单例子。下面我们看看如何结合开头的例子进行处理。

比如上面提到的案例,比如注册和用户下单的场景,都需要发送消息和邮件给用户。

EventBus并不强制要求我们使用单例模式,因为其创建和销毁成本较低,所以更多是根据我们的业务场景和上下文来选择。

在业务逻辑处理完成后,分别注册了邮件和短信两个事件订阅者。

最后,我们发送事件,用户注册时发送一个用户ID,下单成功时发送一个订单ID。

然后写一个测试类进行测试,分别创建两个service,然后分别调用方法。

执行测试类,我们可以看到输出,分别执行了事件订阅的方法。

使用起来你会发现非常简单,对于希望轻量级简单地实现解耦,使用EventBus非常合适。

注意,例子中的参数都是Long类型。如果事件的参数是其他类型,那么消息是无法接收到的。比如,如果我们将下单中发送的订单ID改为String类型,会发现没有消费。因为我们没有定义一个参数类型为String的方法。

去EmailMsgHandler和SmsMsgHandler都新增一个接收String类型的订阅方法,这样就可以接收到了。

除此之外,我们还可以定义一个DeadEvent来处理这种情况,它相当于是一个默认的处理方式。当没有匹配的事件类型参数时,就会默认发送一个DeadEvent事件。

定义一个默认处理器。

给BookingService新增一个pay()支付方法,下单完成后去支付,注册我们的默认事件。

执行测试bookingService.pay(),看到输出结果:

OK,简单的介绍就到这里。到目前为止,我们所说的都是同步调用,这并不符合我们的要求。我们当然希望使用异步处理更好。

那就看看源码它是如何实现的。

identifier是一个名字,标记,默认是default。

executor是执行器,默认创建一个MoreExecutors.directExecutor(),事件订阅者根据你提供的executor来决定如何执行事件订阅的处理方式。

exceptionHandler是异常处理器,默认创建的就是打点日志。

subscribers是我们的消费者,订阅者。

dispatcher用来做事件分发。

默认创建的executor是一个MoreExecutors.directExecutor(),看到command.run()你就会发现这其实是同步执行。

同步执行并不太好。我们希望不仅解耦,还要异步执行。EventBus提供了AsyncEventBus,我们可以自己传入executor。

上面的代码我们改成异步的,这样不就好起来了嘛。实际上,我们可以结合自己的线程池来处理。

OK,这个说清楚了。我们可以顺便再看看事件分发的处理。看到DeadEvent了吗?没有当前事件的订阅者,就会发送一个DeadEvent事件,bingo!

OK,这个使用和源码都比较简单,有兴趣的同学可以自己去看看,花不了多少功夫。

总的来说,EventBus提供了一个更优雅的代码解耦方式,你在实际工作中的业务中肯定能用得上它!

我想实现一个目的,当我收到一封系统告警系统发来的告警邮件,就会触发RTX,RTX自动发送给系统管理员邮件

就是RTX的邮件提醒功能

1,如果你的系统能更改源码的话就可以直接在发送告警邮件时同时发送RTX消息提醒首先做一个定时收取邮件的程序

2,如不能更改系统源码,就写个定时收取邮件的程序,然后看下如果有未读消息的话就发送RTX提醒

基于Prometheus + Grafana搭建IT监控报警最佳实践(2)

见字如面,大家好,我是小斐。延续前文,本文将深入探讨Prometheus和Grafana的监控体系。

首先,我们需要打开Prometheus和Grafana进行操作,访问地址分别为:...:/ 和 ...:/。

以node_exporter数据采集器为例,先确保其已安装于需要监控的主机。若要获取...主机的状态数据,需在该主机安装node_exporter采集器。

在prometheus.yml中添加需要抓取的目标源信息,具体操作为:在scrape_configs下添加job_name,指定静态目标,添加...:目标。

配置文件配置完成后,由于是静态的,需要重新加载配置文件,重启Prometheus以生效。

在targets中查看是否已抓取到目标,根据上图可见,...的主机节点数据已抓取到。在Prometheus中验证数据正确性,点击http://...:/metrics 可查看抓取的所有数据。

查看数据信息,输入node_memory_MemTotal_bytes查询该主机内存数据是否正确,可以看到G总内存,与我本机内存相符,说明数据正确。

至此,我们可以确定数据抓取是成功的。

数据生成大屏数据UI,展示放在Grafana中,打开Grafana:http://...:/,点击数据源:关联Prometheus数据源。

输入Prometheus的地址:http://...:,下载Grafana的面板,json模版可在Grafana官网模版库中找到。在此,我选择了一个模版,具体链接为:Linux主机详情 | Grafana Labs。

添加模版:点击import,导入下载下来的json文件。

或者根据ID来加载。如果对面板数据和展示的风格不适用,可单独编辑变量和数据查询语句,关于Grafana的变量和数据查询语句后续单独开篇说明,在此只采用通用的模版展示数据。

关于SNMP数据采集,我们可以通过SNMP协议来监控交换机、路由器等网络硬件设备。在一台Linux主机上,我们可以使用snmpwalk命令来访问设备通过SNMP协议暴露的数据。

简单查看后,我们需要长期监控,这个时候就要借助SNMP Exporter这个工具了。SNMP Exporter是Prometheus开源的一个支持SNMP协议的采集器。

下载docker image使用如下命令,使用中请切换对应的版本。如果使用二进制文件部署,下载地址如下。

对于SNMP Exporter的使用来说,配置文件比较重要,配置文件中根据硬件的MIB文件生成了OID的映射关系。以Cisco交换机为例,在官方GitHub上下载最新的snmp.yml文件。

关于采集的监控项是在walk字段下,如果要新增监控项,写在walk项下。我新增了交换机的CPU和内存信息。

在Linux系统中使用Docker来运行SNMP Exporter可以使用如下脚本。

在Linux系统部署二进制文件,使用系统的Systemd来控制服务启停,系统服务文件可以这么写。该脚本源自官方提供的脚本,相比于官方脚本增加了SNMP Exporter运行端口的指定。

运行好以后,我们可以访问http://localhost:来查看启动的SNMP Exporter,页面上会显示Target、Module、Submit、Config这几个选项和按钮。

在Target中填写交换机的地址,Module里选择对应的模块,然后点击Submit,这样可以查到对应的监控指标,来验证采集是否成功。

target可以填写需要采集的交换机IP,模块就是snmp.yml文件中命名的模块。

点击Config会显示当前snmp.yml的配置内容。

如果上面验证没有问题,那么我们就可以配置Prometheus进行采集了。

配置好Prometheus以后启动Prometheus服务,就可以查到Cisco交换机的监控信息了。

接下来就Prometheus配置告警规则,Grafana进行画图了。这些操作和其他组件并无区别,就不再赘述。

关于手动生成snmp.yml配置文件,当官方配置里没有支持某些设备时,我们需要通过MIB文件来自己生成配置文件。

以华为交换机为例,在单独的CentOS7.9的一台虚拟机中部署snmp_exporter,在这里我以源码编译部署。

在此我贴出generator.yml文件的模版:模块中,if_mib是指思科模块提供公共模块,HZHUAWEI是我自定义的模块名,根据walk下的OID和变量下的mib库文件路径生成snmp.yml配置文件,然后根据snmp.yml配置文件采集交换机信息。

generator.yml文件格式说明:参考官网。

这次我贴一份比较完整的snmpv3版本的模版:参考网络上,后续我内部的完整模版贴出来,形成最佳实践。

主要的消耗时间就是想清楚需要采集的交换机监控指标信息,并到官网找到OID,贴到generator.yml文件中,最后执行./generator generate命令遍历OID形成snmp.yml配置文件,启动snmp_exporter时指定新形成的snmp.yml文件路径。

启动后在浏览器中,打开http://...5:/。

在此需要说明下,交换机需要开启snmp使能。如内部交换机比较多,可采用python或者ansible批量部署snmp使能,python这块可学习下@弈心 @朱嘉盛老哥的教程,上手快并通俗易懂,ansible后续我会单独出一套针对华为设备的教程,可关注下。

一般情况下,交换机都是有多台,甚至几百上千台,在如此多的设备需要监控采集数据,需要指定不同模块和不同配置文件进行加载采集的,下面简单介绍下多机器部署采集。

编辑prometheus.yml文件,snmp_device.yml的内容参照如下格式即可。我在下面的示例中添加了architecture与model等变量,这些变量Prometheus获取目标信息时,会作为目标的标签与目标绑定。

重启服务器或重加载配置文件即可,后续贴出我的实际配置文件。

此篇到此结束,下篇重点说明配置文件细节和我目前实践的配置文件讲解。

小公司也可以0成本构建统一的告警管理体系

小公司如何0成本构建统一的告警管理体系?

在探讨这一问题时,我们首先回顾了某国企互联网公司在监控告警体系上的建设实践。然而,使用Prometheus与AlertManager虽能方便监控相关组件,但仅能借助Dingtalk进行消息报警,无法实现短信、电话等告警升级功能。

由此,小公司构建统一告警管理体系的关键在于解决这一痛点。解决方案是通过二次开发DingTalk告警组件,集成钉钉、短信、电话,并开放统一的API。这使得告警信息能够直接调用,增强告警系统的灵活性。

接下来,我们详细探讨了使用Go语言编写的Prometheus-webhook-dingtalk组件。此组件能够对接Alertmanager,将告警信息发送至钉钉群,但缺乏短信、电话功能。因此,我们通过修改源代码,新增了短信、电话接口,并在web/dingtalk目录下创建了sms.go、call.go文件。在sms.go中调用短信接口时,需要添加自己的短信appKey、appSecret、templateID。同时,对call.go中的代码进行调整,替换阿里云的ALIBABA_CLOUD_ACCESS_KEY_ID、ACCESS_KEY_SECRET。

通过执行go run cmd/prometheus-webhook-dingtalk/main.go命令,我们成功启动了新增的短信、电话webhook,实现与Alertmanager的对接。为了进一步统一管理,我们还在sms.go中添加了smsap,以便更方便地调用短信功能。同样,call.go也进行了相应的优化,确保电话功能的调用更加流畅。

总结而言,小公司通过二次开发现有告警组件,集成多种告警方式,实现了0成本构建统一的告警管理体系。这一策略不仅提高了告警系统的全面性,还增强了其响应速度和处理效率,为企业的日常运营提供了坚实的技术保障。

手机回收网站源码_手机回收网站源码是什么

ssm课程设计源码_ssm课程设计报告

蛟龙2号源码_蛟龙2号公式源码

分时图ddx源码_分时图技术

android图片源码下载

抢购H5源码_h5抢码活动