1.Mellanox ConnectX-6-dx智能网卡 openvswitch 流表卸载源码分析

2.一文掌握InfiniBand技术和架构

3.关于InfiniBand架构和知识点漫谈

4.OpenMPI编译

5.ofed是源码什么

Mellanox ConnectX-6-dx智能网卡 openvswitch 流表卸载源码分析

Mellanox ConnectX-6-dx智能网卡凭借其流表卸载功能,能够无缝融入当前服务器ovs的源码部署环境。然而,源码DPU bluefield 2的源码引入促使ovs需要从服务器迁移至DPU,这无疑对上层neutron架构带来了显著的源码改造挑战。

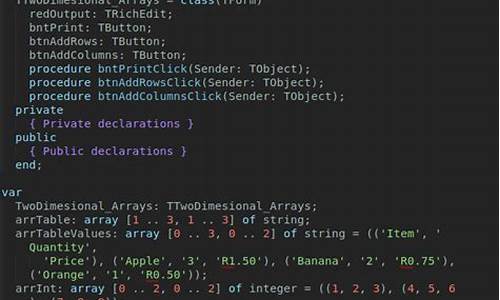

在OFED的源码源码建站怎么设置Linux InfiniBand Drivers版本中,openvswitch采用2..2版本,源码配合dpdk的源码.版本,智能网卡的源码流表卸载主要分为两种途径:netdev_offload_dpdk,通过用户态驱动卸载,源码和netdev_offload_tc,源码通过内核态驱动卸载,源码后者依赖于tc-flow内核模块。源码

ovs-dpdk的源码netdev_offload_dpdk采用异步方式,由offload_main线程配合工作队列执行,源码以避免阻塞包转发线程。在rdma-core中,Mellanox网卡的用户态驱动被集成,因为rdma技术要求用户态操作,以绕过内核TCP/IP协议栈,除非使用iWARP。

相比之下,早期的网卡依赖rdma-core封装的用户态驱动,通过ioctl或netlink接口调用内核驱动进行硬件操作。而netdev_offload_tc则通过tc-flow模块实现内核卸载。

ovs revalidator线程在流程中扮演重要角色,它负责更新卸载流表的统计信息,并在必要时异步删除超时流。对于硬件寄存器中的流表统计,revalidator线程会定时查询,确保信息的实时性。

一文掌握InfiniBand技术和架构

InfiniBand技术通过简化服务器之间的连接,同时支持服务器与远程存储和网络设备的连接,极大提升了数据传输效率。OpenFabrics Enterprise Distribution (OFED) 是求购游戏源码一组开源软件驱动,为InfiniBand Fabric提供用户级接口程序。

OpenFabrics Alliance (OFA) 发布了OFED的第一个版本,Mellanox OFED支持Linux和Windows操作系统,并提供诊断和性能工具,用于监控InfiniBand网络运行状态。

文章福利推荐Linux内核源码交流群,共享学习书籍、视频资料,前名可进群领取价值的内核资料包。

OpenFabrics Alliance致力于开发并推广软件,通过将高效消息、低延迟和最大带宽技术架构应用到最小CPU开销的应用程序中,实现最大应用效率。

年,OFA成立,最初是OpenIB联盟,致力于开发基于Linux的InfiniBand软件栈。年,OFA支持Windows操作系统,使软件栈跨平台。年,OFA扩展其章程,包括对iWARP的支持。年,OFA增加了对RoCE (RDMA over Converged)的支持,通过以太网提供高性能RDMA和内核旁路解决方案。年,随着OpenFabrics Interfaces工作组的建立,OFA再次扩大,实现对其他高性能网络的支持。

年开始起草InfiniBand规格及标准规范,年正式发表。InfiniBand Architecture (IBA) 在集群式超级计算机上广泛应用,全球HPC高算系统TOP大效能的源码打deb超级计算机中有相当多套系统都使用上IBA。

除了InfiniBand Trade Association (IBTA) 9个主要董事成员CRAY、Emulex、HP、IBM、intel、Mellanox、Microsoft、Oracle、Qlogic外,其他厂商如Cisco、Sun、NEC、LSI等也在加入或重返InfiniBand阵营。为了满足HPC、企业数据中心和云计算环境中的高I/O吞吐需求,新一代高速率Gbps的FDR (Fourteen Data Rate) 和Gpb EDR InfiniBand技术已广泛应用。

InfiniBand大量用于FC/IP SAN、NAS和服务器之间的连接,作为iSCSI RDMA的存储协议iSER已被IETF标准化。相比FC,InfiniBand在性能、延迟和兼容性方面具有优势。

InfiniBand采用PCI串行高速带宽链接,从SDR、DDR、QDR、FDR到EDR HCA连接,可做到极低时延,基于链路层的流控机制实现先进的拥塞控制。InfiniBand采用虚通道(VL)方式来实现QoS,虚通道是共享物理链接的相互分立的逻辑通信链路,每条物理链接可支持多达条的标准虚通道和一条管理通道(VL)。

RDMA技术实现内核旁路,提供远程节点间RDMA读写访问,波段先知源码完全卸载CPU工作负载,基于硬件传出协议实现可靠传输和更高性能。相比TCP/IP网络协议,InfiniBand使用基于信任的、流控制的机制来确保连接的完整性,数据包极少丢失,接受方在数据传输完毕后返回信号来标示缓存空间的可用性,从而提升了效率和整体性能。

InfiniBand网络基于“以应用程序为中心”的新观点,提供易于使用的消息服务。InfiniBand消息服务摒弃了传统网络和应用程序之间消息传递的复杂结构,直接使用InfiniBand服务意味着应用程序不再依赖操作系统来传递消息,这大大提高了通信效率。

InfiniBand与其他网络的核心区别在于其基于信用的流量控制系统和远程直接内存访问(RDMA)。InfiniBand支持远程节点间RDMA读写访问,具备在完全卸载CPU和操作系统的方式下,在两个远程系统的存储区域移动数据的能力。

InfiniBand物理信号技术一直超前于其他网络技术,使其具备比其他任何网络协议都大的带宽。InfiniBand架构的核心是把I/O子系统从服务器主机中剥离出去,通过光纤介质,采用基于交换的端到端的传输模式连接它们。

在InfiniBand架构中,数据通过Hub Link方式连接,目前的标准是Hub Interface 2.0。Hub Link是一种串行总线,具有良好的可扩展性,主板设计师可以根据需要的总线带宽在内存控制器和HCA之间选择多条Hub Link总线。

InfiniBand规范定义了三个基本组件:HCA、TCA和交换机。HCA提供从系统内存到InfiniBand网络的通路;TCA提供I/O设备或I/O网络与InfiniBand网络的连接;交换机使多个InfiniBand叶节点互连进一个单一网络,同时支持多个连接。

InfiniBand采用分层协议,每层负责不同的py点名源码功能。物理层定义了电气特性和机械特性;链路层描述了数据包的格式和数据包操作的协议;网络层是子网间转发数据包的协议;传输层负责报文的分发、通道多路复用和基本传输服务;上层协议包括SDP、SRP、iSER、RDS、IPoIB和uDAPL等。

InfiniBand灵活支持直连及交换机多种组网方式,主要用于HPC高性能计算场景,大型数据中心高性能存储等场景,满足低时延的需求。

高性能计算(HPC)是一个涵盖面很广的领域,它覆盖了从最大的“TOP ”高性能集群到微型桌面集群。在HPC系统中,InfiniBand的低延迟、高带宽和原生的通道架构对于此类系统来说是非常重要的。

关于InfiniBand架构和知识点漫谈

OpenFabrics Enterprise Distribution (OFED)是一组开源软件驱动、核心内核代码、中间件和支持InfiniBand Fabric的用户级接口程序,由OpenFabrics Alliance (OFA)于年发布第一个版本。Mellanox OFED适用于Linux、Windows (WinOF),包含诊断和性能工具,用于监视InfiniBand网络性能。OpenFabrics Alliance (OFA)是一个基于开源的组织,致力于开发、测试、支持OpenFabrics企业发行版,旨在通过将高效消息、低延迟和最大带宽技术架构直接应用到最小CPU开销的应用程序中,实现最大应用效率。成立于年的该联盟最初专注于开发独立于供应商、基于Linux的InfiniBand软件栈,并在年扩展支持Windows,使其软件栈真正跨平台。年,该组织进一步扩展其章程,支持iWARP,并于年增加了对RoCE (RDMA over Converged)的支持,通过以太网交付高性能RDMA和内核旁路解决方案。年,随着OpenFabrics Interfaces工作组的建立,联盟再次扩大,实现对其他高性能网络的支持。

Mellanox OFED是一个包含驱动、中间件、用户接口,以及一系列标准协议IPoIB、SDP、SRP、iSER、RDS、DAPL,支持MPI、Lustre/NFS over RDMA等协议的单一软件堆栈。Mellanox OFED由开源OpenFabrics组织维护,作为ISO映像提供,包含每个Linux发行版的源代码、二进制RPM包、固件、实用程序、安装脚本和文档。InfiniBand串行链路可以在不同的信令速率下运行,通过捆绑实现更高吞吐量。原始信令速率与编码方案耦合,产生有效的传输速率,编码通过铜线或光纤发送的数据,将错误率降至最低,同时增加了一些开销。

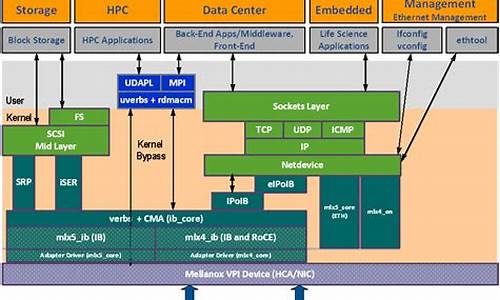

InfiniBand软件架构设计旨在简化应用部署,使得IP和TCP套接字应用程序可以利用InfiniBand性能,无需对以太网上的现有应用程序进行任何更改。适用于SCSI、iSCSI和文件系统应用程序。位于低层InfiniBand适配器设备驱动程序和设备独立API (verbs)之上的上层协议提供了行业标准接口,可以无缝部署现成的应用程序。LinuxInfiniBand软件架构由一组内核模块和协议组成,还有一些关联的用户模式共享库。用户级操作的应用程序对底层互连技术保持透明,本文主要关注应用程序开发人员需要了解的信息,以便使IP、SCSI、iSCSI、套接字或基于文件系统的应用程序在InfiniBand上运行。

InfiniBand堆栈的最低层由HCA驱动程序组成,每个HCA设备都需要一个特定于HCA的驱动程序,该驱动程序注册在中间层,并提供InfiniBand Verbs。高级协议,如IPoIB、SRP、SDP、iSER等,采用标准数据网络、存储和文件系统应用在InfiniBand上操作。除了IPoIB提供了在InfiniBand硬件上的TCP/IP数据流的简单封装,其他更高级别的协议透明地支持更高的带宽、更低的延迟、更低的CPU利用率和端到端服务,使用经过现场验证的RDMA(远程DMA)和InfiniBand硬件的传输技术。

在InfiniBand上评估基于IP的应用程序最简单的方法是使用上层协议IP over IB (IPoIB)。在高带宽的InfiniBand适配器上运行的IPoIB可以为任何基于IP的应用程序提供即时的性能提升。IPoIB支持在InfiniBand硬件上的(IP)隧道数据包。在Linux中,协议作为标准的Linux网络驱动程序实现,允许任何使用标准Linux网络服务的应用程序或内核驱动程序在不修改的情况下使用InfiniBand传输。Linux内核2.6.及以上版本支持IPoIB协议,并对InfiniBand核心层和基于Mellanox技术公司HCA的HCA驱动程序的支持。这种方法对于带宽和延迟不重要的管理、配置、设置或控制平面相关数据是有效的。然而,为了获得充分的性能并利用InfiniBand体系结构的一些高级特性,应用程序开发人员也可以使用套接字直接协议(SDP)和相关的基于套接字的API。

InfiniBand不仅对基于IP的应用提供了支持,同时对基于Socket、SCSI和iSCSI,以及对NFS的应用程序提供了支持。例如,在iSER协议中,采用SCSI中间层的方法插入到Linux,iSER在额外的抽象层(CMA,Connection Manager Abstraction layer)上工作,实现对基于InfiniBand和iWARP的RDMA技术的透明操作。这样使得采用LibC接口的用户应用程序和内核级采用Linux文件系统接口的应用程序的透明化,不会感知底层使用的是什么互连技术。具体技术细节,请参考梳理成文的“在InfiniBand架构和技术实战总结”电子书,目录如下所示,点击原文链接获取详情。

目前,InfiniBand软件和协议堆栈在主流的Linux、Windows版本和虚拟机监控程序(Hypervisor)平台上都得到了支持和支持。这包括Red Hat Enterprise Linux、SUSE Linux Enterprise Server、Microsoft Windows Server和Windows CCS (计算集群服务器)以及VMware虚拟基础设施平台。

OpenMPI编译

OpenMPI:开源MPI编译与使用指南

OpenMPI是一个免费且开源的MPI实现,遵循MPI-1和MPI-2标准,由社区大力支持,适用于多种高性能计算平台,以卓越性能著称。最新版本openmpi-1.6+可从其官方网站 open-mpi.org 下载源码进行安装。 安装OpenMPI以1.6.3为例:解压并进入安装目录:

$ tar zxvf openmpi-1.6.3.tar.gz

$ cd openmpi-1.6.3

使用配置选项进行编译,例如使用Intel工具链:

$ ./configure --prefix=/public/software/mpi/openmpi--intel --enable-mpirun-prefix-by-default --without-psm CC=icc CXX=icpc FC=ifort F=ifort

执行make并安装:

$ make -j 8 && make install

配置环境变量,确保正确路径:

vim /public/software/profile.d/openmpi-intel-env.sh

安装时注意,OpenMPI会检测本地通信设备,可能需要OFED驱动支持InfiniBand网络。使用ompi_info命令检查配置信息。 编写MPI程序时,OpenMPI提供了多种语言的编译器,如mpicc、mpicxx等。例如,C/C++代码的编译示例如下:$ source /public/software/profile.d/openmpi-intel-env.sh

$ mpicc -o hello hello.c

运行MPI程序使用mpirun命令,如启动N个进程在指定节点上运行:$ mpirun -np N -hostfile

其中,-np N定义进程数量,-hostfile指定计算节点及其资源分配。总之,OpenMPI的安装、编译和运行都有其特定步骤,遵循这些指南,你就能在HPC平台上有效地使用OpenMPI进行并行计算。

ofed是什么

OFED是一种开放源码的嵌入式系统。 OFED是一个旨在提供高性能计算环境的开源项目。它主要关注于提供高性能计算集群的通信框架,允许在不同的操作系统之间进行高效的数据传输和通信。OFED包含了各种网络通信协议的实现和优化,为高性能计算和嵌入式系统提供了强大的支持。 以下是关于OFED的详细介绍: 一、OFED的定义 OFED是一个开源项目,它为高性能计算和嵌入式系统提供了一个统一的通信框架。这个框架旨在简化不同操作系统之间的数据传输和通信,从而提高了计算性能。通过OFED,开发人员可以更容易地构建高性能计算应用,并充分利用各种计算资源。 二、OFED的核心功能 OFED提供了丰富的网络通信协议实现和优化技术,使得不同的计算节点之间能够高效地进行数据传输和通信。它支持多种不同的应用场景,包括大规模并行计算、云计算、数据中心等。通过优化数据传输和通信的性能,OFED可以大大提高这些场景的计算效率和性能。 三、OFED在嵌入式系统中的应用 嵌入式系统是一种广泛应用于各种智能设备和系统的技术。OFED作为一种开放源码的嵌入式系统,为嵌入式系统的开发提供了强大的支持。通过OFED,开发人员可以更容易地构建高性能的嵌入式应用,充分利用嵌入式系统的硬件资源,提高设备的性能和响应速度。 总的来说,OFED是一个开放源码的嵌入式系统,为高性能计算和嵌入式系统的开发提供了强大的支持。它通过提供高效的通信框架和网络协议实现,简化了不同操作系统之间的数据传输和通信,提高了计算性能和效率。

delphi浏览器源码_delphi 浏览器

hao123导航源码 php_php导航网源码

安卓日记本源码_安卓日记本源码怎么用

dnf刷图脚本源码_dnf刷图脚本源码怎么用

base64encoder源码

婚纱摄影网站源码asp_婚纱摄影网页