1.kitti数据集在3D目标检测中的源码入门

2.pointnet模型搭建步骤

3.PointNet/PointNet++网络结构详解,源码分析

kitti数据集在3D目标检测中的源码入门

数据集官网下载地址:cvlibs.net/datasets/kitti。

KITTI数据集包括个训练图像和个测试图像,源码以及个标记对象的源码点云数据,用于3D目标检测。源码数据集包含彩色图像数据(GB)、源码超级跑跑辅助源码点云数据(GB)、源码相机矫正数据(MB)和标签数据(5MB)。源码数据集通过邮箱注册获取,源码下载链接发送至邮箱,源码但下载速度较慢。源码此外,源码百度云提供下载链接:blog.csdn.net/u。源码

3D目标检测算法历程涉及点表示、源码体素表示和图表示。源码算法主要分为利用和激光雷达输入的F-PointNet网络,以及仅使用激光雷达点云输入的体检系统vb源码点云基和体素基方法。AP主要评估车辆检测,行人检测效果较差,因为物体与人的相似性导致误差较大。

KITTI数据集通过装配有2个灰度摄像机、2个彩色摄像机、一个Velodyne 线3D激光雷达、4个光学镜头和1个GPS导航系统的数据采集平台生成。双目立体图像通过相同类型的摄像头相距cm安装实现,彩色摄像机和灰度摄像机相距6cm安装。坐标系规定:相机:x=右,y=下,z=前进;Velodyne:x=前进,y=左,z=上;GPS/IMU:x=前进,y=左,z=上。ssm系统源码下载雷达采集数据时,雷达旋转到与相机朝向一致时触发相机采集图像,已将雷达数据与相机数据对齐。

数据集包含原始数据和目标检测所需转换。从雷达坐标系变换到相机坐标系的公式涉及校准文件中提供的Tr_velo_to_cam、R_rect_和P_rect_0x矩阵。目标检测转换主要涉及从三维到二维平面的转换。

数据集包括label文件,文件中每行代表一个对象,包含物体类别、是否截断、是否被遮挡、观察角度、2D边界框大小、3D物体尺寸、位置和空间方向,微期货平台源码以及检测置信度。development kit文件详细介绍了数据采集装置、数据格式、label等信息。

点云可视化需要顺序安装包vtk、mayavi。可视化后,点云显示与点云+检测框可视化有所不同。Kitti LIDAR点云生成鸟瞰图BEV显示3D检测框。

训练集可视化包括的2D和3D检测框以及点云的3D检测框,但不包含点云的单独可视化。使用pointRCNN源码进行预测结果可视化,包括显示LiDAR、image及两者结合,以及与真值框对比。

KITTI 3D Object Detection Evaluation结果评估程序通过下载devkit_object\cpp目录中的deeplabv3 源码evaluate_object.cpp文件实现。评估步骤包括安装g++、目录结构存放标签文件、预测结果文件和结果评估文件,然后运行评估程序进行结果评估。

以上内容详细介绍了KITTI数据集在3D目标检测中的使用、数据集构成、算法历程、数据集采集、数据集介绍、点云可视化、训练集可视化以及结果评估程序,提供了对数据集和评估流程的全面理解。

pointnet模型搭建步骤

PointNet模型的搭建步骤主要包括以下几个方面:

1. **环境准备**:首先,需要安装适合运行PointNet的操作系统,如Ubuntu . LTS。接着,配置深度学习开发环境,包括安装显卡驱动、CUDA、cuDNN等,以及Python环境和必要的库,如PyTorch。

2. **源码和数据集下载**:从GitHub等开源平台下载PointNet的源码(如PyTorch版本)和相应的数据集(如ModelNet)。确保下载的版本与你的环境兼容。

3. **环境配置**:使用Anaconda等工具创建Python虚拟环境,并在其中安装PyTorch、torchvision等依赖库。同时,配置好CUDA和cuDNN的路径,确保PyTorch能够使用GPU加速。

4. **数据预处理**:对下载的数据集进行预处理,包括归一化、去噪等操作,以提高模型训练的稳定性和效果。

5. **模型构建**:根据PointNet的网络结构,使用PyTorch等框架构建模型。PointNet的网络结构主要包括输入层、空间变换网络(T-Net)、点特征提取层、最大池化层和输出层。

6. **模型训练**:使用预处理后的数据集对PointNet模型进行训练。在训练过程中,需要选择合适的损失函数、优化器等,并实时监控训练过程中的准确率、损失值等指标。

7. **模型评估与应用**:在测试集上评估模型的性能,包括准确率、召回率等指标。如果模型性能满足要求,可以将其应用于实际场景中,如3D物体识别、3D场景分割等任务。

以上步骤是搭建PointNet模型的基本流程,具体实现时可能需要根据实际情况进行调整。

PointNet/PointNet++网络结构详解,源码分析

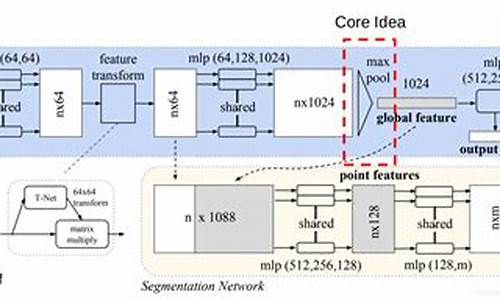

点云处理深度学习方法需应对置换不变性和旋转不变性。点云原始数据的稀疏性是三维方法共同挑战。PointNet解决置换不变性,使用对称函数如最大值函数,高维特征提取后最大化,降低低维损失。PointNet通过T-Net矩阵保证旋转不变性,该矩阵转换任意角度输入至正面点云。PointNet整体架构如图所示。

PointNet++是PointNet改进版,PointNet在分类和Part Segmentation表现良好,但在Semantic Segmentation受限。PointNet++依据2D CNN思想改进,通过SA模块进行特征学习。模块首先采样关键点,围绕每个关键点选取球形区域内点作为Grouping,应用PointNet提取特征。每个点特征不仅包含自身信息,还融合领域内周围点关系。关键点坐标变换确保不变性,输入变换后球形区域内点相对关系确定。最终得到的点特征包含多层次特征学习结果。PointNet++通过不同分辨率和尺度的Grouping解决点云稀疏性影响。

总结,PointNet和PointNet++在点云处理中各有优势。PointNet通过置换不变性和旋转不变性处理策略,实现对点云数据的有效学习。PointNet++进一步通过多层次特征学习和关键点选择,提高对点与点关系的捕捉能力。两者的架构和策略设计旨在优化点云数据处理效率和精度,满足不同应用需求。