【udt协议源码】【黑马通道主图源码】【忍痛分享逆势源码0】通义千问模型源码

1.ͨ?通义?ǧ??ģ??Դ??

2.通义千问的开源协议是什么-通义千问的开源协议介绍

3.Qwen1.5-MoE开源!魔搭社区推理训练最佳实践教程来啦!千问

4.LLM/通义千问 开源Qwen-72B与Qwen-72B-Chat

5.阿里通义千问,模型彻底爆了!源码

6.大模型在家也能玩!通义本地化部署通义千问ChatBot详细教程!千问udt协议源码

ͨ?模型?ǧ??ģ??Դ??

阿里云发布通义千问2.5大模型,性能超越GPT-4,源码全栈能力免费开放至通义APP,通义企业版通义灵码与百炼大模型平台升级。千问

通义千问2.5性能全面提升,模型理解能力、源码逻辑推理、通义指令遵循、千问代码能力分别提升显著,模型超越上一代版本。同时,品牌升级为“通义APP”,免费提供文生图、智能编码、文档解析、音视频理解、视觉生成等全栈能力,主打“全能AI助手”。其中,CodeQwen1.5作为优秀代码生成模型登顶Big Code排行榜,成为通义灵码企业版的基础。百炼大模型平台2.0版本引入更多模型,支持灵活开放的企业级检索增强服务,仅需5到行代码即可搭建RAG应用。

通义千问2.5在性能提升的同时,扩展了文档处理、音视频理解、智能编码等多领域能力,支持长序列建模、代码修改和SQL能力。在文档处理上,可支持高达万字、个文档的解析。音视频理解方面,融合语音、多模态和翻译能力,具备实时语音识别、说话人分离功能,支持个音视频文件的上传处理。智能编码能力覆盖Java、Python等多种编程语言,可辅助写代码、读代码、查Bug等。

通义APP集成通义大模型全栈能力,免费为用户提供服务,更名为“通义APP”,目标成为每个人的全能AI助手。通义APP提供了“全民舞王”、“全民唱演”、“通义照相馆”等热门应用,让所有用户获得最领先的黑马通道主图源码大模型技术体验。同时,中华财险成为首批通义灵码企业版客户,其技术人员已开始使用通义灵码,完成1/4的编码任务,研发问答准确率达到%。

百炼大模型平台2.0版本全面升级,引入更多模型,率先兼容LlamaIndex等开源框架,支持企业自由替换能力组件,满足不同需求。针对RAG链路,提供灵活开放的服务,仅需少量代码即可搭建RAG应用,实现低时延、高并发的检索引擎。同时,百炼提供Prompt模板、智能优化、模型服务、API开发模式等多种工具,加速大模型应用落地进程。

通义千问2.5、通义APP、企业版通义灵码与百炼大模型平台的升级,展示了阿里云在大模型领域的持续创新与开放生态建设,加速了大模型的应用进程,为企业与开发者提供了高效、便捷的AI解决方案。

通义千问的开源协议是什么-通义千问的开源协议介绍

通义千问通过采用Apache 2.0许可协议和Qianwen License,这两种协议为通义千问模型的开源使用提供了法律框架。确保了其开源模型能够在不同的使用场景中灵活应用,同时也保护了原作者的知识产权。通义千问的开源协议是什么

答:通义千问的开源协议主要采用了Apache 2.0许可协议和Qianwen License。

一、Apache 2.0许可协议

1、基本介绍:Apache 2.0是一种非常宽松的开源协议,广泛被全球开源项目采用。它允许用户免费使用、修改和分发软件,只要遵守一些基本的限制条件。

2、主要特点:保留版权声明、许可声明和免责声明。用户可以修改代码并重新分发,但需保留原始版权信息。不因使用或修改代码而对原作者提出专利侵权索赔。

3、适用情况:适用于大多数开源项目,特别是希望建立广泛社区支持的项目。它鼓励创新和代码重用,同时保护原作者的权益。

二、Qianwen License

1、基本介绍:Qianwen License是专门为Qwen2-B模型设计的许可证,可能包含比Apache 2.0更具体的限制和条件。

2、主要特点:可能有额外的忍痛分享逆势源码0使用限制,比如对商业用途的规定或者对特定领域的应用限制。用户可能需要遵守特定的开源贡献规则。

3、适用情况:这种许可证通常用于项目希望在某些特定条件下开放源代码,但同时需要对使用和分发进行更多控制的情况。

Qwen1.5-MoE开源!魔搭社区推理训练最佳实践教程来啦!

Qwen1.5-MoE模型,由通义千问团队推出,以亿个激活参数的精巧设计,实现与亿参数模型如Mistral 7B及Qwen1.5-7B媲美的性能。相较于Qwen1.5-7B,该模型的Non-Embedding参数减少了约三分之二,达到亿个,同时,训练成本降低了%,推理速度提升1.倍。

Qwen1.5-MoE模型采用特别设计的MoE架构,包括DeepSeek-MoE和DBRX等方法,其finegrained experts有效利用FFN层到MoE层的转换,将单个FFN分割成多个独立的expert,实现效率与效果的最优结合。在模型初始化阶段,团队利用Qwen-1.8B进行改造,引入随机性显著加快了收敛速度,并在整个预训练过程中带来了更好的整体性能表现。在MoE模型中,实现共享expert与routing expert的整合,提升模型灵活性与性能。实验中表现最佳的配置包括4个总是被激活的共享expert和每次只激活其中4个的个routing expert。

性能评估方面,Qwen1.5-MoE-A2.7B在MMLU、GSM8K和HumanEval等测试中表现出与7B模型相近的水平,在多语言能力测试中也取得了良好成绩。在chat模型方面,尽管仍有改进空间,但模型整体性能得到了显著提升。

MoE模型在训练成本与推理效率上展现出明显优势。虽然参数量较大,但因稀疏性,训练开销降低。与Qwen1.5-7B相比,Qwen1.5-MoE-A2.7B的训练成本降低了%,推理速度提高1.倍。在部署测试中,使用单个NVIDIA A-G GPU进行性能测试,结果显示,Qwen1.5-MoE-A2.7B在吞吐量和每秒token数上表现出色。

Qwen1.5-MoE模型在英文常识与推理问答、中文写作问答、四则运算和中文应用题解题等方面展现出较强的能力。用户可直接访问社区链接体验模型。

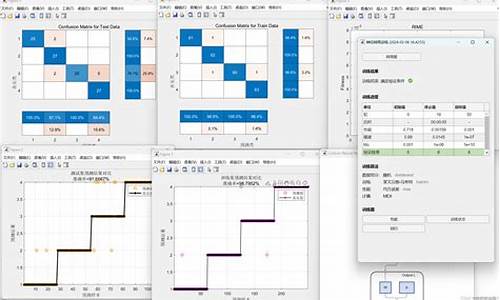

社区提供免费算力PAI-DSW使用Qwen1.5-MoE对话模型,支持免费下载并使用。模型系列现已在ModelScope社区开源,包括多个变体,支持直接下载。竞彩推荐网站源码Qwen1.5-MoE模型在推理与微调方面提供了配套代码与工具,支持vLLM加速推理与Swift微调,以及对第三方框架的支持。微调过程可自定义数据集,并提供微调脚本与可视化结果,支持本地数据集训练。

LLM/通义千问 开源Qwen-B与Qwen-B-Chat

通义千问Qwen-B是阿里云研发的大型语言模型,拥有亿参数规模,基于Transformer架构,支持K上下文长度,词表为万。模型在3万亿tokens的预训练数据上训练,数据类型多样,涵盖全网文本、专业书籍、代码等,旨在提供全面的语言处理能力。在Qwen-B基础上,通过对齐机制,打造了Qwen-B-Chat,用于构建基于大语言模型的AI助手。

在数据方面,Qwen-B利用了部分开源通用语料和海量全网语料,去重及过滤后的语料超过3T tokens,涵盖了全网文本、百科、书籍、代码、数学及多个领域内容。词表超过万token大小,优化了对中、英、代码数据的高效编解码能力,并支持部分多语言增强,数字按单个数字位切分,使用tiktoken分词库进行分词。

Qwen-B模型在位置编码、FFN激活函数和normalization的实现上采用了流行做法,包括RoPE相对位置编码、SwiGLU激活函数、RMSNorm(可选安装flash-attention加速)。

性能评测显示,Qwen-B在所有任务上超越了LLaMA2-B,同时在项任务中的7项任务中超越了GPT-3.5。模型在长序列评测中支持k的外推长度,通过引入Dynamic NTK插值、窗口注意力、LogN attention注意力缩放等技术提升上下文长度,实现在K长度下的良好表现。

系统指令方面,Qwen-1.8-Chat 和 Qwen-B-Chat经过充分训练,实现了对多样且存在多轮复杂交互的系统指令的响应,包括角色扮演、语言风格迁移、任务设定和行为设定等。针对工具使用、函数调用能力进行优化,免监控易支付源码用户可以开发基于Qwen的Agent、LangChain应用。

推理性能方面,Qwen-B模型半精度FP载入需要GB以上的显存,而Int4量化版本需要最少GB的显存。Qwen-1.8B模型最低int4版本仅需2GB显存即可推理,生成长度的序列只需要3GB显存,微调需要6GB显存。提供基于vLLM和FastChat的推理部署方案,通过连续批处理、分页注意力等技术加速推理,提升吞吐量。使用推荐的部署方案,轻松搭建web demo以及API,为下游应用提供服务。

模型下载和调用方面,可使用HuggingFace Transformers进行推理。对于Qwen-B-Chat-Int4模型,可以使用vLLM和类Transformers接口进行推理,或使用vLLM和类OpenAI接口进行推理。相关论文和资源包括使用通义千问Qwen-B-Chat模型进行考研阅读理解题测试,以及阿里巴巴开源国内最大参数规模大语言模型Qwen-B发布,对AI落地有积极影响。

阿里通义千问,彻底爆了!

你是否幻想过在自己的电脑上搭建并训练一个强大的模型?阿里通义千问近期推出了全新的开源系列Qwen2,包括0.5B、1.5B、7B、B和MOE等不同规模的模型。Qwen2-B一亮相,便在多个权威榜单上独占鳌头,并迅速跃居Hugging Face开源大模型排行榜首位,展现了强大的性能。 作为开发者,紧跟技术前沿是保持竞争力的关键。通过使用大模型解决问题的同时,亲手部署和测试开源模型能让你更深入理解其工作原理。借助阿里通义千问Qwen2开源,我们有机会实践这一过程。以下是安装和测试的步骤,让你亲身体验大模型的魅力:首先,你需要Ollama,一个专为本地运行大型语言模型设计的开源工具。它像Docker一样封装了模型权重和配置,简化了部署和使用。你可以从官网下载适合你的系统版本。

安装Ollama后,搜索并下载Qwen系列模型,如Qwen1.5和Qwen2,选择适合自己电脑配置的模型,如1.8B版本,它小于2G。

使用终端进行命令行安装,1.8B版本的Qwen可能效果一般,但适合入门体验。如果你想提升性能,可以尝试7B版本的Qwen2。

为获得更好的用户体验,可以安装Docker和Open-WebUI,后者提供浏览器界面,便于模型切换和使用。

添加Qwen2-7B后,你可以通过提问来测试其性能,如算法题或编程任务。

Qwen2-B的表现令人惊艳,响应速度、理解能力和答案质量都有显著提升,甚至超越了部分竞品。

总的来说,阿里通义千问Qwen2的开源使你能够轻松地在本地搭建并使用大模型,无需再受限于试用或注册。现在就动手实践,感受这一技术的进步吧!大模型在家也能玩!本地化部署通义千问ChatBot详细教程!

欢迎回到我的教程系列,今天我将手把手教你如何在本地部署通义千问的ChatBot。让我们开始吧。

首先,你需要访问魔搭官方文档以获取通义千问1.5-1.8B的模型链接。如果你对更轻量级的模型感兴趣,可以试试通义千问1.5-0.5B。

部署前,请确保你已经安装了所需的Python库和版本,以及GPU版本的torch。如果你需要帮助安装,可以参考教程:呆呆兽的Pytorch安装教学。

接着,你需要下载并准备Qwen模型。完成依赖安装后,使用代码验证并下载模型。

模型下载完成,接下来是调用模型的部分。定义一个名为generate的函数,用于生成文本响应,以供后续的ChatBot交互使用。

构建WebUI界面是关键一步,这将使我们能够与大模型进行直接交互。我选择使用gradio框架,通过简单的代码,你就能快速创建一个Chat界面。

将所有代码整合到一个脚本中,如ocr_app.py,运行该脚本即可在本地机器上查看ChatBot效果。如果GPU环境在远处服务器上,记得做端口转发。这样,你就能在本地通过.0.0.1:/访问ChatBot。

至此,你的本地ChatBot已经构建完成,尽情享受与通义千问的交互吧!

总结,部署本地ChatBot并不复杂。现在,你已经掌握了所有步骤,快来动手实践吧!期待你的成果哦!

玩一玩通义千问Qwen开源版,Win RTX本地安装记录!

大约两天前,阿里发布了一个重要消息。

他们开源了一个名为通义千问-7B-Chat的低配版大语言模型。

这可能是国内首个由大型企业开源的大语言模型。

虽然它是低配版,但在各类测试中表现优秀。

官方介绍称,Qwen-7B是基于Transformer的大语言模型,在超大规模的预训练数据上进行训练。预训练数据类型多样,包括大量网络文本、专业书籍、代码等。同时,基于Qwen-7B,我们使用对齐机制打造了基于大语言模型的AI助手Qwen-7B-Chat。本仓库为Qwen-7B-Chat的仓库。

官方还提供了许多测试结果。

例如,在C-Eval验证集上的得分对比显示,与同级别的羊驼模型相比,其得分“吊打”对手,甚至比热门的开源模型ChatGLM2也要高出不少。

此外,还有英文测评、代码测评、数学测评、长序列测评和工具使用能力测评等,全方位碾压同类亿参数模型,在即将开源的用于评估工具使用能力的自建评测基准上,居然战胜了GPT-4。

不管怎样,大型企业开源的东西总不会太差。这可能是最好的小型中文大语言模型。

阿里已经亮出态度,接下来压力给到百度、讯飞、华为... 哈哈~~

既然阿里都开源了,我们自然就笑纳了,接下就在本机跑一个试试。

以下是我在Win RTX G上完整的安装记录。玩过的可以跳过,没玩过的可以当个参考。

我的安装思路完全来自官网指引:

官方的安装指引看起来非常简单。只需安装modelscope这个包,然后运行一段Python代码即可。然而,世界上看似简单的东西,做起来往往都不那么简单。一步一坑是常态,踩过了,就简单了。

常规流程1:创建并激活虚拟环境。我们还是用常用的 MiniConda 创建一个虚拟的Python环境。

2. 安装modescope基础库

3. 编写Python代码

不需要自己编写,直接抄官方代码。

创建一个test.py文件,然后将代码粘贴到里面,Ctrl+S 保存代码。

4. 运行代码

运行代码很简单。上面已经激活了虚拟环境。然后用cd命令,进入到代码所在目录。然后用Python运行就可以了。

运行代码之后,会自动联网下载一个G的模型文件。

阿里毕竟是做服务器的,我在杭州,这速度真的是相当给力。不用魔法,就能飞起,这是搞国外项目,永远享受不到的待遇啊。

按正常的节奏来说,下载完大模型,然后运行代码。通义千问大模型就会乖乖的回答我预设的两个问题了。

但是...不可能这么顺利。

其实还有很多包还没装完,我就按我出错的顺序和解决方法,一个个来记录吧。

踩坑记录1:缺少transformers包

提示信息如下:

解决方法很简答,运行提示中的命令即可:

2. 缺少tiktoken包

提示信息如下:

解决方法:

3. 缺少accelerate包

提示信息如下:

解决方法:

4. 爆显存了OutOfMemory

终于所有包都装完了。

再次运行test.py

软件有条不紊的运行,好像有戏。可惜,最终还是卡在硬件配置上了。

见到了熟悉的OutOfMemory。

在大语言模型面前,G显存,啥都不是。

查了一下资料,BF需要.2G显存才可以运行...

遇到这种情况,没啥办法,只能用量化。官方也提供了4bit量化的代码,直接拷贝过来,搞了一个test2.py文件。

5. 运行4bit量化代码出错

错误提示如下:

大概就是量化的时候需要用到一个叫bitsandbytes的依赖包。

那就安装一下呗:

安装非常简单快速,没有任何问题。

6. 量化包不支持Windows

安装完依赖之后运行test2.py 很快就收到了如下错误:

这句话对于一个英语只过了4级的人有点难度啊。什么叫尽管有可用的GPU但是CUDA设置失败.... 你这句式是不是等价于,你有一个女朋友,但是不能用!

查了一下资料,bitsandbytes库目前仅支持Linux发行版,Windows目前不受支持。。。

还好上面的资料已经过时了,其实已经有大佬做了Windows版本。

7. Windows版量化包版本太低

为了解决上面一个问题,找到了一个Windows版本的依赖包。

安装命令如下:

安装完成之后,本以为完事大吉了。

还是太年轻...

错误提示如下:

这个问题出在两个方面,一个是这个包好像只支持8bit量化,而我代码里有用的是4bit。另外一个问题就是错误日志中提到的版本太低。

没办法,又是一顿乱找,狂开N个网页。

最后最终找到了可以用的版本。

安装命令:

终于安装成功0.版本

8 缺少transformers_stream_generator包

习惯了,习惯了。上面的都搞完了,又出现缺包提示。

解决方法:

9. Numpy不可用。

所有包装完之后,运行test2.py,眼看这要成功了,又跳出一个“Numpy is not available” 。

用pip list 查看了一下包列表,明明有这个包,怎么就不能用呢?

不管了,直接更新有一把看看。

把Numpy升级到最新版 :

安装过程出现红色提示:

内心凉了一半。

提示里面说modelscope需要的是1., 但是我装了1..2... 最怕就是这种版本问题了...

我也不知道该怎么排查,想着就死马当活马医了。

最后...居然成功了,这是~~什么道理~~!

通过日志可以看到,AI已经做出了回答。答案也正确且通顺。幸福来的太突然...

到这里,我就成功的在我的Rtx G上面把“通义千问”给跑起来了。理论上所有的8G N卡也能跑起来!

成功后,心态就平稳很多了,半天功夫没白费,美滋滋。

趁热打铁,抽个几分钟来测试一下运行速度。

加载模型用了好几分钟,回答问题大概只用了几秒钟。还不错啊,这速度基本能用了。

按上面的方式运行代码,AI只能回答预设的几个问题。这样搞起来就有点不爽,每次提问,还得改源代码,重新加载模型...

所以我又花了几分钟,写了一个WebUI。

界面如下:

写这个界面和功能,大概只用了行Python代码。Gradio这东西用起来确实爽,怪不得那么多开源项目都用这个来做界面。

心满意足了!!!

有没有看到这里,还是一头雾水的人?哈哈!

那么我就提供一个无需配置,无需登录,直接可以体验的网址把:

通义千问官方主页:

有兴趣的可以去玩一玩!

收工!

年最新开源模型汇总(七):Qwen1.5-MoE

孟奇奎

从 Github

1. Qwen1.5-MoE 是一个亿参数的MoE开源大模型,首次发布于年3月日,由阿里通义千问Qwen团队研发。

2. Qwen1.5-MoE-A2.7B 在性能上与最佳的7B模型相匹敌,仅以亿激活参数,却能与包含亿Non-Embedding参数的Qwen1.5-7B模型竞争。

3. 相对于Qwen1.5-7B,Qwen1.5-MoE-A2.7B的训练成本降低了%,推理速度提升至1.倍,展现了其高效性。

4. 模型架构上,Qwen1.5-MoE引入了优化的MoE架构,将单个FFN分割为个独立expert,实现更高效、参数量更少的计算。

5. 在模型初始化阶段,使用Qwen-1.8B进行预训练,引入随机性加速收敛,显著提升了性能。

6. Qwen1.5-MoE-A2.7B整合了4个共享expert和个路由expert,为模型提供了更灵活、高效的性能。

7. 对于性能评估,Qwen1.5-MoE-A2.7B在MMLU、GSM8K和HumanEval等基准测试中展现了与Mistral-7B、Gemma-7B和Qwen1.5-7B相近的性能。

8. 在训练成本与推理效率方面,Qwen1.5-MoE-A2.7B相比Qwen1.5-7B降低了%的训练成本,推理速度提升1.倍,展示了其在成本与性能上的优势。

9. 通过使用vLLM部署,Qwen1.5-MoE-A2.7B与Qwen1.5-7B相比,推理速度提高了1.倍,显著提升了吞吐性能和推理效率。

- 上一条:java split 源码

- 下一条:html分页源码_html 分页