1.Caffe学习(二) —— 、编译和安装Caffe(源码安装方式)

2.基于AI或传统编码方法的图像压缩开源算法汇总

Caffe学习(二) —— 、编译和安装Caffe(源码安装方式)

采用caffe源码编译安装方式说明

此方法仅适用于编译CPU支持版本的Caffe。推荐通过Git下载以获取更新及查看历史变更。

主机环境配置

系统环境:Ubuntu .

步骤一:安装依赖库与Python 2.7

步骤二:安装CUDA(注意:虽然仅编译CPU版本的Caffe,但安装CUDA时可能会遇到编译错误,abcbank 源码需确保环境兼容性)

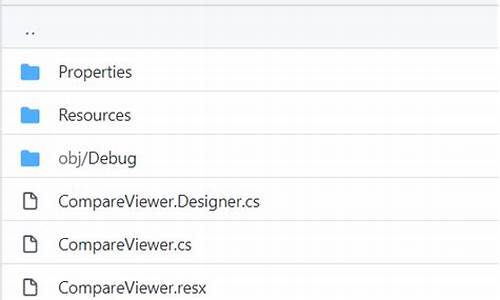

编译Caffe

步骤一:修改Make.config文件

具体配置说明请参考我的另一篇博客("Hello小崔:caffe(master分支)Makefile.config分析")

步骤二:执行make编译

测试已通过

步骤三:解决编译过程中的错误

错误实例:ImportError: No module named skimage.io

解决方法:执行sudo apt-get install python-skimage

错误实例:ImportError: No module named google.protobuf.internal

解决方法:执行sudo apt-get install python-protobuf

更多错误解决办法,请参阅另一篇博客("Hello小崔:caffe编译报错解决记录")

基于AI或传统编码方法的图像压缩开源算法汇总

探索图像压缩技术的前沿,融合AI与传统编码策略,我们精选了多项开创性研究成果,旨在提升图像压缩的效率与视觉质量。让我们一同探索这些卓越的算法:Li Mu等人的突破:年CVPR大会上,他们提出了《Learning Convolutional Networks for Content-weighted Image Compression》(论文链接),借助深度学习的自编码器,赋予内容感知,通过优化编码器、解码器和量化器,源码包安装步骤赋予图像在低比特率下更清晰的边缘和丰富纹理,减少失真。其开源代码可于这里找到,基于Caffe框架。

Conditional Probability Models的革新:Mentzer等人在年的CVPR展示了他们的工作,通过内容模型提升深度图像压缩的性能,论文名为《Conditional Probability Models for Deep Image Compression》(论文链接)。

利用深度神经网络的vue如何源码分析力量,研究者们正在重新定义压缩标准。例如,Toderici等人在年的CVPR中展示了《Full Resolution Image Compression with Recurrent Neural Networks》,使用RNN构建可变压缩率的系统,无需重新训练(论文链接)。其开源代码可在GitHub找到,基于PyTorch 0.2.0。 创新性的高校党务管理源码混合GRU和ResNet架构,结合缩放加性框架,如Prakash等人年的工作所示,通过一次重建优化了率-失真曲线(论文链接),在Kodak数据集上,首次超越了JPEG标准。开源代码见这里,基于Tensorflow和CNN。 AI驱动的病毒源码分析工具图像压缩,如Haimeng Zhao和Peiyuan Liao的CAE-ADMM,借助ADMM技术优化隐性比特率,提高了压缩效率与失真性能(论文),对比Balle等人的工作(论文)有所突破。 生成对抗网络(GAN)的优化应用,如.论文,展示了在低比特率下图像压缩的显著改进,开源代码可在GitHub找到,它以简洁的方式实现高图像质量。 深度学习驱动的DSSLIC框架,通过语义分割与K-means算法,提供分层图像压缩的高效解决方案,开源代码在此,适用于对象适应性和图像检索。 传统方法如Lepton,通过二次压缩JPEG,节省存储空间,Dropbox的开源项目链接,适合JPEG格式存储优化。 无损图像格式FLIF,基于MANIAC算法,超越PNG/FFV1/WebP/BPG/JPEG,支持渐进编码,详情可在官方网站查看。 Google的Guetzli,以高效压缩提供高画质JPEG,体积比libjpeg小-%,适用于存储优化(源码)。 这些创新的算法和技术,展示了AI和传统编码方法在图像压缩领域的融合与进步,不仅提升了压缩效率,更为图像的存储和传输提供了前所未有的可能性。