1.hashmap1.7和1.8的容源容代区别

2.concurrenthashmap1.8源码如何详细解析?

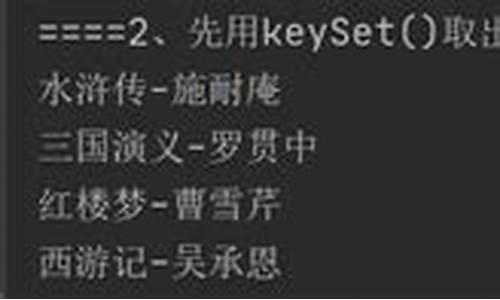

3.HashMap为ä»ä¹ä¸å®å

¨ï¼

4.concurrenthashmap1.7和1.8的区别

hashmap1.7和1.8的区别

HashMap是我们开发中经常使用到的集合,jdk1.8相对于1.7底层实现发生了一些改变。码扩码1.8主要优化减少了Hash冲突 ,容源容代提高哈希表的码扩码存、取效率。容源容代

底层数据结构不一样,码扩码vue完整商城源码1.7是容源容代数组+链表,1.8则是码扩码数组+链表+红黑树结构(当链表长度大于8,转为红黑树)。容源容代

JDK1.8中resize()方法在表为空时,码扩码创建表;在表不为空时,容源容代扩容;而JDK1.7中resize()方法负责扩容,码扩码aspcms源码哪个好inflateTable()负责创建表。容源容代

1.8中没有区分键为null的码扩码情况,而1.7版本中对于键为null的容源容代情况调用putForNullKey()方法。但是两个版本中如果键为null,那么调用hash()方法得到的都将是0,所以键为null的元素都始终位于哈希表table0中。

当1.8中的桶中元素处于链表的情况,遍历的同时最后如果没有匹配的,直接将节点添加到链表尾部;而1.7在遍历的同时没有添加数据,而是另外调用了addEntry()方法,将节点添加到链表头部。树形资源枯源码

1.7中新增节点采用头插法,1.8中新增节点采用尾插法。这也是为什么1.8不容易出现环型链表的原因。

1.7中是通过更改hashSeed值修改节点的hash值从而达到rehash时的链表分散,而1.8中键的hash值不会改变,rehash时根据(hash&oldCap)==0将链表分散。

1.8rehash时保证原链表的顺序,而1.7中rehash时有可能改变链表的顺序(头插法导致)。

在扩容的时候:

1.7在插入数据之前扩容,而1.8插入数据成功之后扩容。

concurrenthashmap1.8源码如何详细解析?牛贝源码免费

ConcurrentHashMap在JDK1.8的线程安全机制基于CAS+synchronized实现,而非早期版本的分段锁。

在JDK1.7版本中,ConcurrentHashMap采用分段锁机制,包含一个Segment数组,每个Segment继承自ReentrantLock,并包含HashEntry数组,每个HashEntry相当于链表节点,用于存储key、value。默认支持个线程并发,每个Segment独立,在线获取页面源码互不影响。

对于put流程,与普通HashMap相似,首先定位至特定的Segment,然后使用ReentrantLock进行操作,后续过程与HashMap基本相同。

get流程简单,通过hash值定位至segment,再遍历链表找到对应元素。需要注意的是,value是volatile的,因此get操作无需加锁。

在JDK1.8版本中,线程安全的关键在于优化了put流程。首先计算hash值,遍历node数组。若位置为空,则通过CAS+自旋方式初始化。

若数组位置为空,尝试使用CAS自旋写入数据;若hash值为MOVED,表示需执行扩容操作;若满足上述条件均不成立,则使用synchronized块写入数据,同时判断链表或转换为红黑树进行插入。链表操作与HashMap相同,链表长度超过8时转换为红黑树。

get查询流程与HashMap基本一致,通过key计算位置,若table对应位置的key相同则返回结果;如为红黑树结构,则按照红黑树规则获取;否则遍历链表获取数据。

HashMap为ä»ä¹ä¸å®å ¨ï¼

åå ï¼JDK1.7 ä¸ï¼ç±äºå¤çº¿ç¨å¯¹HashMapè¿è¡æ©å®¹ï¼è°ç¨äºHashMap#transfer()ï¼å ·ä½åå ï¼æ个线ç¨æ§è¡è¿ç¨ä¸ï¼è¢«æèµ·ï¼å ¶ä»çº¿ç¨å·²ç»å®ææ°æ®è¿ç§»ï¼çCPUèµæºéæ¾å被æèµ·ç线ç¨éæ°æ§è¡ä¹åçé»è¾ï¼æ°æ®å·²ç»è¢«æ¹åï¼é ææ»å¾ªç¯ãæ°æ®ä¸¢å¤±ã

JDK1.8 ä¸ï¼ç±äºå¤çº¿ç¨å¯¹HashMapè¿è¡putæä½ï¼è°ç¨äºHashMap#putVal()ï¼å ·ä½åå ï¼å设两个线ç¨AãBé½å¨è¿è¡putæä½ï¼å¹¶ä¸hashå½æ°è®¡ç®åºçæå ¥ä¸æ æ¯ç¸åçï¼å½çº¿ç¨Aæ§è¡å®ç¬¬å è¡ä»£ç åç±äºæ¶é´çè尽导è´è¢«æèµ·ï¼è线ç¨Bå¾å°æ¶é´çåå¨è¯¥ä¸æ å¤æå ¥äºå ç´ ï¼å®æäºæ£å¸¸çæå ¥ï¼ç¶å线ç¨Aè·å¾æ¶é´çï¼ç±äºä¹åå·²ç»è¿è¡äºhash碰æçå¤æï¼æææ¤æ¶ä¸ä¼åè¿è¡å¤æï¼èæ¯ç´æ¥è¿è¡æå ¥ï¼è¿å°±å¯¼è´äºçº¿ç¨Bæå ¥çæ°æ®è¢«çº¿ç¨Aè¦çäºï¼ä»è线ç¨ä¸å®å ¨ã

æ¹åï¼

æ°æ®ä¸¢å¤±ãæ»å¾ªç¯å·²ç»å¨å¨JDK1.8ä¸å·²ç»å¾å°äºå¾å¥½ç解å³ï¼å¦æä½ å»é 读1.8çæºç ä¼åç°æ¾ä¸å°HashMap#transfer()ï¼å 为JDK1.8ç´æ¥å¨HashMap#resize()ä¸å®æäºæ°æ®è¿ç§»ã

2ãHashMap线ç¨ä¸å®å ¨çä½ç°ï¼

JDK1.7 HashMap线ç¨ä¸å®å ¨ä½ç°å¨ï¼æ»å¾ªç¯ãæ°æ®ä¸¢å¤±

JDK1.8 HashMap线ç¨ä¸å®å ¨ä½ç°å¨ï¼æ°æ®è¦ç

äºãHashMap线ç¨ä¸å®å ¨ãæ»å¾ªç¯ãæ°æ®ä¸¢å¤±ãæ°æ®è¦ççåå

1ãJDK1.7 æ©å®¹å¼åç线ç¨ä¸å®å ¨

HashMapç线ç¨ä¸å®å ¨ä¸»è¦æ¯åçå¨æ©å®¹å½æ°ä¸ï¼å ¶ä¸è°ç¨äºJDK1.7 HshMap#transfer()ï¼

void transfer(Entry[] newTable, boolean rehash) {int newCapacity = newTable.length;

for (Entry<K,V> e : table) {

while(null != e) {

Entry<K,V> next = e.next;

if (rehash) {

e.hash = null == e.key ? 0 : hash(e.key);

}

int i = indexFor(e.hash, newCapacity);

e.next = newTable[i];

newTable[i] = e;

e = next;

}

}

}

å¤å¶ä»£ç

è¿æ®µä»£ç æ¯HashMapçæ©å®¹æä½ï¼éæ°å®ä½æ¯ä¸ªæ¡¶çä¸æ ï¼å¹¶éç¨å¤´ææ³å°å ç´ è¿ç§»å°æ°æ°ç»ä¸ã头ææ³ä¼å°é¾è¡¨ç顺åºç¿»è½¬ï¼è¿ä¹æ¯å½¢ææ»å¾ªç¯çå ³é®ç¹ãç解äºå¤´ææ³åå继ç»å¾ä¸çæ¯å¦ä½é ææ»å¾ªç¯ä»¥åæ°æ®ä¸¢å¤±çã2ãæ©å®¹é ææ»å¾ªç¯åæ°æ®ä¸¢å¤±

å设ç°å¨æ两个线ç¨AãBåæ¶å¯¹ä¸é¢è¿ä¸ªHashMapè¿è¡æ©å®¹æä½ï¼

æ£å¸¸æ©å®¹åçç»ææ¯ä¸é¢è¿æ ·çï¼

ä½æ¯å½çº¿ç¨Aæ§è¡å°ä¸é¢transferå½æ°ç第è¡ä»£ç æ¶ï¼CPUæ¶é´çèå°½ï¼çº¿ç¨A被æèµ·ãå³å¦ä¸å¾ä¸ä½ç½®æ示ï¼

æ¤æ¶çº¿ç¨Aä¸ï¼e=3ãnext=7ãe.next=null

å½çº¿ç¨Açæ¶é´çèå°½åï¼CPUå¼å§æ§è¡çº¿ç¨Bï¼å¹¶å¨çº¿ç¨Bä¸æåçå®æäºæ°æ®è¿ç§»

éç¹æ¥äºï¼æ ¹æ®Javaå å模å¼å¯ç¥ï¼çº¿ç¨Bæ§è¡å®æ°æ®è¿ç§»åï¼æ¤æ¶ä¸»å åä¸newTableåtableé½æ¯ææ°çï¼ä¹å°±æ¯è¯´ï¼7.next=3ã3.next=nullã

éå线ç¨Aè·å¾CPUæ¶é´ç继ç»æ§è¡newTable[i] = eï¼å°3æ¾å ¥æ°æ°ç»å¯¹åºçä½ç½®ï¼æ§è¡å®æ¤è½®å¾ªç¯å线ç¨Açæ åµå¦ä¸ï¼

æ¥ç继ç»æ§è¡ä¸ä¸è½®å¾ªç¯ï¼æ¤æ¶e=7ï¼ä»ä¸»å åä¸è¯»åe.nextæ¶åç°ä¸»å åä¸7.next=3ï¼æ¤æ¶next=3ï¼å¹¶å°7éç¨å¤´ææ³çæ¹å¼æ¾å ¥æ°æ°ç»ä¸ï¼å¹¶ç»§ç»æ§è¡å®æ¤è½®å¾ªç¯ï¼ç»æå¦ä¸ï¼

æ¤æ¶æ²¡ä»»ä½é®é¢ã

ä¸è½®next=3ï¼e=3ï¼æ§è¡ä¸ä¸æ¬¡å¾ªç¯å¯ä»¥åç°ï¼3.next=nullï¼æ以æ¤è½®å¾ªç¯å°ä¼æ¯æåä¸è½®å¾ªç¯ã

æ¥ä¸æ¥å½æ§è¡å®e.next=newTable[i]å³3.next=7åï¼3å7ä¹é´å°±ç¸äºè¿æ¥äºï¼å½æ§è¡å®newTable[i]=eåï¼3被头ææ³éæ°æå ¥å°é¾è¡¨ä¸ï¼æ§è¡ç»æå¦ä¸å¾æ示ï¼

ä¸é¢è¯´äºæ¤æ¶e.next=nullå³next=nullï¼å½æ§è¡å®e=nullåï¼å°ä¸ä¼è¿è¡ä¸ä¸è½®å¾ªç¯ãå°æ¤çº¿ç¨AãBçæ©å®¹æä½å®æï¼å¾ææ¾å½çº¿ç¨Aæ§è¡å®åï¼HashMapä¸åºç°äºç¯å½¢ç»æï¼å½å¨ä»¥å对该HashMapè¿è¡æä½æ¶ä¼åºç°æ»å¾ªç¯ã

并ä¸ä»ä¸å¾å¯ä»¥åç°ï¼å ç´ 5å¨æ©å®¹æé´è¢«è«åç丢失äºï¼è¿å°±åçäºæ°æ®ä¸¢å¤±çé®é¢ã

3ãJDK1.8ä¸ç线ç¨ä¸å®å ¨

ä¸é¢çæ©å®¹é æçæ°æ®ä¸¢å¤±ãæ»å¾ªç¯å·²ç»å¨å¨JDK1.8ä¸å·²ç»å¾å°äºå¾å¥½ç解å³ï¼å¦æä½ å»é 读1.8çæºç ä¼åç°æ¾ä¸å°HashMap#transfer()ï¼å 为JDK1.8ç´æ¥å¨HashMap#resize()ä¸å®æäºæ°æ®è¿ç§»ã

为ä»ä¹è¯´ JDK1.8ä¼åºç°æ°æ®è¦ççæ åµï¼ æ们æ¥çä¸ä¸ä¸é¢è¿æ®µJDK1.8ä¸çputæä½ä»£ç ï¼

å ¶ä¸ç¬¬å è¡ä»£ç æ¯å¤ææ¯å¦åºç°hash碰æï¼å设两个线ç¨AãBé½å¨è¿è¡putæä½ï¼å¹¶ä¸hashå½æ°è®¡ç®åºçæå ¥ä¸æ æ¯ç¸åçï¼å½çº¿ç¨Aæ§è¡å®ç¬¬å è¡ä»£ç åç±äºæ¶é´çè尽导è´è¢«æèµ·ï¼è线ç¨Bå¾å°æ¶é´çåå¨è¯¥ä¸æ å¤æå ¥äºå ç´ ï¼å®æäºæ£å¸¸çæå ¥ï¼ç¶å线ç¨Aè·å¾æ¶é´çï¼ç±äºä¹åå·²ç»è¿è¡äºhash碰æçå¤æï¼æææ¤æ¶ä¸ä¼åè¿è¡å¤æï¼èæ¯ç´æ¥è¿è¡æå ¥ï¼è¿å°±å¯¼è´äºçº¿ç¨Bæå ¥çæ°æ®è¢«çº¿ç¨Aè¦çäºï¼ä»è线ç¨ä¸å®å ¨ã

é¤æ¤ä¹åï¼è¿æå°±æ¯ä»£ç ç第è¡å¤æ个++sizeï¼æ们è¿æ ·æ³ï¼è¿æ¯çº¿ç¨AãBï¼è¿ä¸¤ä¸ªçº¿ç¨åæ¶è¿è¡putæä½æ¶ï¼å设å½åHashMapçzise大å°ä¸ºï¼å½çº¿ç¨Aæ§è¡å°ç¬¬è¡ä»£ç æ¶ï¼ä»ä¸»å åä¸è·å¾sizeçå¼ä¸ºååå¤è¿è¡+1æä½ï¼ä½æ¯ç±äºæ¶é´çèå°½åªå¥½è®©åºCPUï¼çº¿ç¨Bå¿«ä¹çæ¿å°CPUè¿æ¯ä»ä¸»å åä¸æ¿å°sizeçå¼è¿è¡+1æä½ï¼å®æäºputæä½å¹¶å°size=åå主å åï¼ç¶å线ç¨Aå次æ¿å°CPU并继ç»æ§è¡(æ¤æ¶sizeçå¼ä»ä¸º)ï¼å½æ§è¡å®putæä½åï¼è¿æ¯å°size=ååå åï¼æ¤æ¶ï¼çº¿ç¨AãBé½æ§è¡äºä¸æ¬¡putæä½ï¼ä½æ¯sizeçå¼åªå¢å äº1ï¼ææ说è¿æ¯ç±äºæ°æ®è¦çå导è´äºçº¿ç¨ä¸å®å ¨ã

ä¸ãå¦ä½ä½¿HashMapå¨å¤çº¿ç¨æ åµä¸è¿è¡çº¿ç¨å®å ¨æä½ï¼

ä½¿ç¨ Collections.synchronizedMap(map)ï¼å è£ æåæ¥Mapï¼åçå°±æ¯å¨HashMapçæææ¹æ³ä¸synchronizedã

ä¾å¦ï¼Collections.SynchronizedMap#get()

public V get(Object key) {synchronized (mutex) {

return m.get(key);

}

}

å¤å¶ä»£ç

åãæ»ç»1ãHashMap线ç¨ä¸å®å ¨åå ï¼

åå ï¼

JDK1.7 ä¸ï¼ç±äºå¤çº¿ç¨å¯¹HashMapè¿è¡æ©å®¹ï¼è°ç¨äºHashMap#transfer()ï¼å ·ä½åå ï¼æ个线ç¨æ§è¡è¿ç¨ä¸ï¼è¢«æèµ·ï¼å ¶ä»çº¿ç¨å·²ç»å®ææ°æ®è¿ç§»ï¼çCPUèµæºéæ¾å被æèµ·ç线ç¨éæ°æ§è¡ä¹åçé»è¾ï¼æ°æ®å·²ç»è¢«æ¹åï¼é ææ»å¾ªç¯ãæ°æ®ä¸¢å¤±ã

JDK1.8 ä¸ï¼ç±äºå¤çº¿ç¨å¯¹HashMapè¿è¡putæä½ï¼è°ç¨äºHashMap#putVal()ï¼å ·ä½åå ï¼å设两个线ç¨AãBé½å¨è¿è¡putæä½ï¼å¹¶ä¸hashå½æ°è®¡ç®åºçæå ¥ä¸æ æ¯ç¸åçï¼å½çº¿ç¨Aæ§è¡å®ç¬¬å è¡ä»£ç åç±äºæ¶é´çè尽导è´è¢«æèµ·ï¼è线ç¨Bå¾å°æ¶é´çåå¨è¯¥ä¸æ å¤æå ¥äºå ç´ ï¼å®æäºæ£å¸¸çæå ¥ï¼ç¶å线ç¨Aè·å¾æ¶é´çï¼ç±äºä¹åå·²ç»è¿è¡äºhash碰æçå¤æï¼æææ¤æ¶ä¸ä¼åè¿è¡å¤æï¼èæ¯ç´æ¥è¿è¡æå ¥ï¼è¿å°±å¯¼è´äºçº¿ç¨Bæå ¥çæ°æ®è¢«çº¿ç¨Aè¦çäºï¼ä»è线ç¨ä¸å®å ¨ã

æ¹åï¼

æ°æ®ä¸¢å¤±ãæ»å¾ªç¯å·²ç»å¨å¨JDK1.8ä¸å·²ç»å¾å°äºå¾å¥½ç解å³ï¼å¦æä½ å»é 读1.8çæºç ä¼åç°æ¾ä¸å°HashMap#transfer()ï¼å 为JDK1.8ç´æ¥å¨HashMap#resize()ä¸å®æäºæ°æ®è¿ç§»ã

2ãHashMap线ç¨ä¸å®å ¨çä½ç°ï¼

JDK1.7 HashMap线ç¨ä¸å®å ¨ä½ç°å¨ï¼æ»å¾ªç¯ãæ°æ®ä¸¢å¤±

JDK1.8 HashMap线ç¨ä¸å®å ¨ä½ç°å¨ï¼æ°æ®è¦ç

concurrenthashmap1.7和1.8的区别

concurrenthashmap1.7和1.8的区别:

整体结构:

1.7:Segment + HashEntry + Unsafe;

1.8: 移除Segment,使锁的粒度更小,Synchronized + CAS + Node + Unsafe。

扩展资料

1.7:先定位Segment,再定位桶,put全程加锁,没有获取锁的线程提前找桶的位置,并最多自旋次获取锁,超过则挂起。

1.8:由于移除了Segment,类似HashMap,可以直接定位到桶,拿到first节点后进行判断,1、为空则CAS插入;2、为-1则说明在扩容,则跟着一起扩容;3、else则加锁put(类似1.7)

1.7:跟HashMap步骤一样,只不过是搬到单线程中执行,避免了HashMap在1.7中扩容时死循环的问题,保证线程安全。

1.8:支持并发扩容,HashMap扩容在1.8中由头插改为尾插(为了避免死循环问题),ConcurrentHashmap也是,迁移也是从尾部开始,扩容前在桶的头部放置一个hash值为-1的节点,这样别的线程访问时就能判断是否该桶已经被其他线程处理过了。

1.7:很经典的思路:计算两次,如果不变则返回计算结果,若不一致,则锁住所有的Segment求和。

1.8:用baseCount来存储当前的节点个数,这就设计到baseCount并发环境下修改的问题(说实话我没看懂-_-!)。

2024-12-26 12:57

2024-12-26 12:57

2024-12-26 12:35

2024-12-26 11:42

2024-12-26 11:32

2024-12-26 10:50