1.U-Net+与FCN的区别+医学表现+网络详解+创新

2.FCOS:论文与源码解读

3.改进CNN&FCN的晶圆缺陷分割系统

4.Ubuntu系统-FFmpeg安装及环境配置

5.matlab BP神经网络的训练算法中训练函数(traingdm 、trainlm、trainbr)的实现过程及相应的VC源代码

6.深度学习语义分割篇——FCN原理详解篇

U-Net+与FCN的区别+医学表现+网络详解+创新

UNet论文: 地址 UNet源代码: 地址 UNet和FCN的区别 UNet相比FCN,结构更加对称,解码部分采用合并操作(concatenation)而非FCN的加法操作(summation),FCN的hatlab源码解码部分较为简单,仅使用反卷积,UNet在反卷积后通过合并操作补充特征信息,提高了分割精度。 UNet在医学图像分割中的表现 UNet在医学图像分割中表现良好,其原因在于医学图像的特点,如高分辨率、局部特征明显等。UNet的编码部分提取局部特征,解码部分通过反卷积与合并操作恢复特征尺寸,提高了分割精度。 UNet网络模型 UNet由编码路径和解码路径组成。编码路径用于特征提取,降低分辨率以增强模型对小扰动的鲁棒性。解码路径利用编码路径的抽象特征恢复图像尺寸,合并操作补充信息,减少上采样时的信息损失。 UNet的创新点 UNet的创新点包括Overlap-tile策略,通过镜像填充预处理图像,使输出尺寸与输入尺寸相同,同时提供上下文信息提高预测精度。数据增强策略,通过随机弹性变形增加数据量。加权损失函数,yy进入频道源码通过预先计算权重图调整不同像素的损失权重,强化边缘学习。 UNet的不足与改进 UNet++作者分析了UNet的不足,并提出了改进方法,包括网络结构的优化和数据增强策略的改进。 拓展应用 UNet适用于大尺寸医学图像的分割,通过切块处理,UNet能够提供边缘信息,克服分割区域边缘处理问题。UNet家族的发展包括了UNet++等改进模型,进一步提高了分割性能。FCOS:论文与源码解读

FCOS:全称为全卷积单阶段目标检测,它在锚框自由领域中占有重要地位,与RetinaNet在锚框基础领域中地位相似。它沿用ResNet+FPN架构,通过实验证明,在相同backbone和neck层下,锚框自由方法可以取得比锚框基础方法更好的效果。 FCOS借鉴了语义分割的思想,成功地去除了锚框先验,实现了逐点的目标检测,是全卷积网在目标检测领域的延伸。代码比锚框基础类简单,非常适合入门。1. 动机

锚框基础类目标检测方法存在多处缺点,FCOS通过去除锚框,提出了简单、温柔且有力的大主宰源码分析目标检测模型。2. 创新点

FCOS借鉴了语义分割的思想,实现了去除锚框、逐点的目标检测。以年提出的全卷积网(FCN)为例,FCOS借鉴了FCN的思想,将其应用于目标检测,主要步骤包括生成先验、分配正负样本和设计bbox assigner。3. 模型整体结构与流程

训练时,包括生成先验和正负样本分配。FCOS的先验是将特征图上的每一点映射回原始图像,形成逐点对应关系。分配正负样本时,正样本表示预测目标,负样本表示背景。3.1 训练时

在训练阶段,先通过prior generate生成先验,然后进行bbox assign。在分配过程中,FCOS利用了FPN层解决ambigous点的问题,通过多尺度特征融合和逐层分配目标来解决。3.1.1 prior generate

FCOS通过映射特征图上的每一点回原始图像,形成点对点对应关系,生成先验。通过公式计算映射关系,其中s表示步长。3.1.2 bbox assigne

分配正负样本时,FCOS借鉴了anchor base方法的uip源码keil移植正负样本分配机制,通过设计bbox assigner解决ambigous点问题。分配流程包括计算输出值、对输出进行exp操作和引入可学习参数scale,以及使用FPN层分而治之,进一步解决ambigous问题。3.1.3 centerness

FCOS额外预测了centerness分支,以过滤远离目标中心的点,提高检测质量。centerness值范围为0~1,越靠近中心,值越大。测试时,最终score=cls_score*centerness。3.1.4 loss

损失函数包括focal loss、IoU loss和交叉熵损失,用于训练分类、定位和centerness分支。3.2 模型结构

模型继续沿用ResNet和FPN层,进行公平比较。FPN输出的特征层与RetinaNet类似,但FCOS在FPN输出的最后一层特征层上进行额外卷积,与RetinaNet在输入特征层上进行额外卷积不同。在推理阶段,注意centerness与分类分数的乘积作为最终得分,且需要进行NMS操作。4. 总结与未来方向

FCOS是一个简单、温柔、有力量的网站余额宝源码锚框自由方法,地位重要,思想借鉴于语义分割,流程类似传统目标检测,包括生成先验、正负样本匹配、bbox编码和NMS等,额外加入centerness分支以提升检测质量。 未来,FCOS的研究方向可能包括更深入的理论分析、模型优化和跨领域应用探索。5. 源码

mmdetection提供了FCOS的配置文件和代码实现,包括多个版本和改进。了解这些细节有助于深入理解FCOS的实现和优化策略。改进CNN&FCN的晶圆缺陷分割系统

随着半导体行业的快速发展,半导体晶圆的生产需求与日俱增,然而在生产过程中不可避免地会出现各种缺陷,这直接影响了半导体芯片产品的质量。因此,基于机器视觉的晶圆表面检测方法成为研究热点。本文针对基于机器视觉的晶圆表面缺陷检测算法进行深入研究。

在实验中,我们采用三种方式对样本晶圆进行成像。第一种方式使用工业显微相机,配备白色环光,成像分辨率高达×,位深度为,视野约为5.5mm ×3.1mm。第二种方式使用相机 MER--GM,配有蓝色环光和2倍远心镜头,物距mm,成像分辨率×,位深度,视野宽4.4mm,精度为2jum。第三种方式采用相机 Manta G-B,白色环光LTS-RN-W,镜头TY-A,物距mm,成像分辨率×,位深度8,视野宽3mm,精度1 jum。

传统的基于CNN的分割方法在处理晶圆缺陷时存在存储开销大、效率低下、像素块大小限制感受区域等问题。而全卷积网络(FCN)能够从抽象特征中恢复每个像素所属的类别,但在细节提取和空间一致性方面仍有不足。

本文提出改进DUC(dense upsampling convolution)和HDC(hybrid dilated convolution),通过学习一系列上采样滤波器一次性恢复label map的全部分辨率,解决双线性插值丢失信息的问题,实现端到端的分割。

系统整合包括源码、环境部署视频教程、数据集和自定义UI界面等内容。

参考文献包括关于机器视觉缺陷检测的研究综述、产品缺陷检测方法、基于深度学习的产品缺陷检测、基于改进的加权中值滤波与K-means聚类的织物缺陷检测、基于深度学习的子弹缺陷检测方法、机器视觉表面缺陷检测综述、基于图像处理的晶圆表面缺陷检测、非接触超声定位检测研究、基于深度学习的人脸识别方法研究等。

Ubuntu系统-FFmpeg安装及环境配置

FCN-4是一个应用于音频自动标注的全卷积神经网络,使用该网络进行mp3音频自动标注任务需要Librosa依赖库和ffmpeg工具。Librosa库的安装问题中,若安装结果中出现提示内容,说明librosa依赖库安装成功。在调用librosa包过程中,可能会遇到缺失其他相关依赖的问题,如缺少_bz2模块和_lzma模块,这需要将python3.6路径下的_bz2库拷贝到python3.7对应目录下,同时保证python3.7的目录下存在bz库文件,或从网上下载或从其他存在该文件的环境中复制到目标环境。对于找不到sndfile库的问题,使用命令行执行安装指令。在安装FFmpeg工具时,首先需要下载安装wget工具,然后下载并解压ffmpeg的源码安装包。在下载过程中,如果遇到无法通过认证检查的情况,可以通过在命令行中加入取消认证检查的选项来解决。下载完成后,使用解压命令将安装包解压至指定目录。接下来,创建ffmpeg文件夹作为安装路径,并进入源码包目录,执行config程序完成安装配置。若执行config程序时报错“nasm/yasm not found or too old. Use …”,需要先安装yasm,然后再重新执行配置程序。完成配置后,执行编译&安装指令,安装完成后,ffmpeg应存在于指定的安装路径下。配置环境变量时,将ffmpeg的绝对路径添加到PATH环境变量中。若在检测ffmpeg安装情况时出现找不到共享库文件的错误,需要在/etc/ld.so.conf.d/路径下创建文件“ffmpeg.conf”,并写入/usr/local/ffmpeg/lib路径。最后,通过命令行输入“which ffmpeg”或“ffmpeg -h”来测试是否配置成功。若以上步骤完成仍报错“audioread.exceptions.NoBackendError”,可以考虑修改库文件中的后端调用指令,将COMMAND = (‘ffmpeg’, ‘avconv’) 改为 COMMAND = (’/usr/local/ffmpeg/bin/ffmpeg’, ‘avconv’)。不同环境的配置可能会有所不同,因此可能遇到的问题也会有所差异,遇到未提及的问题时,应根据报错信息在搜索引擎中查找解决方案。

matlab BP神经网络的训练算法中训练函数(traingdm 、trainlm、trainbr)的实现过程及相应的VC源代码

VC源代码?你很搞笑嘛。。

给你trainlm的m码

function [out1,out2] = trainlm(varargin)

%TRAINLM Levenberg-Marquardt backpropagation.

%

% <a href="matlab:doc trainlm">trainlm</a> is a network training function that updates weight and

% bias states according to Levenberg-Marquardt optimization.

%

% <a href="matlab:doc trainlm">trainlm</a> is often the fastest backpropagation algorithm in the toolbox,

% and is highly recommended as a first choice supervised algorithm,

% although it does require more memory than other algorithms.

%

% [NET,TR] = <a href="matlab:doc trainlm">trainlm</a>(NET,X,T) takes a network NET, input data X

% and target data T and returns the network after training it, and a

% a training record TR.

%

% [NET,TR] = <a href="matlab:doc trainlm">trainlm</a>(NET,X,T,Xi,Ai,EW) takes additional optional

% arguments suitable for training dynamic networks and training with

% error weights. Xi and Ai are the initial input and layer delays states

% respectively and EW defines error weights used to indicate

% the relative importance of each target value.

%

% Training occurs according to training parameters, with default values.

% Any or all of these can be overridden with parameter name/value argument

% pairs appended to the input argument list, or by appending a structure

% argument with fields having one or more of these names.

% show Epochs between displays

% showCommandLine 0 generate command line output

% showWindow 1 show training GUI

% epochs Maximum number of epochs to train

% goal 0 Performance goal

% max_fail 5 Maximum validation failures

% min_grad 1e- Minimum performance gradient

% mu 0. Initial Mu

% mu_dec 0.1 Mu decrease factor

% mu_inc Mu increase factor

% mu_max 1e Maximum Mu

% time inf Maximum time to train in seconds

%

% To make this the default training function for a network, and view

% and/or change parameter settings, use these two properties:

%

% net.<a href="matlab:doc nnproperty.net_trainFcn">trainFcn</a> = 'trainlm';

% net.<a href="matlab:doc nnproperty.net_trainParam">trainParam</a>

%

% See also trainscg, feedforwardnet, narxnet.

% Mark Beale, --, ODJ //

% Updated by Orlando De Jes鷖, Martin Hagan, Dynamic Training 7--

% Copyright - The MathWorks, Inc.

% $Revision: 1.1.6..2.2 $ $Date: // :: $

%% =======================================================

% BOILERPLATE_START

% This code is the same for all Training Functions.

persistent INFO;

if isempty(INFO), INFO = get_info; end

nnassert.minargs(nargin,1);

in1 = varargin{ 1};

if ischar(in1)

switch (in1)

case 'info'

out1 = INFO;

case 'check_param'

nnassert.minargs(nargin,2);

param = varargin{ 2};

err = nntest.param(INFO.parameters,param);

if isempty(err)

err = check_param(param);

end

if nargout > 0

out1 = err;

elseif ~isempty(err)

nnerr.throw('Type',err);

end

otherwise,

try

out1 = eval(['INFO.' in1]);

catch me, nnerr.throw(['Unrecognized first argument: ''' in1 ''''])

end

end

return

end

nnassert.minargs(nargin,2);

net = nn.hints(nntype.network('format',in1,'NET'));

oldTrainFcn = net.trainFcn;

oldTrainParam = net.trainParam;

if ~strcmp(net.trainFcn,mfilename)

net.trainFcn = mfilename;

net.trainParam = INFO.defaultParam;

end

[args,param] = nnparam.extract_param(varargin(2:end),net.trainParam);

err = nntest.param(INFO.parameters,param);

if ~isempty(err), nnerr.throw(nnerr.value(err,'NET.trainParam')); end

if INFO.isSupervised && isempty(net.performFcn) % TODO - fill in MSE

nnerr.throw('Training function is supervised but NET.performFcn is undefined.');

end

if INFO.usesGradient && isempty(net.derivFcn) % TODO - fill in

nnerr.throw('Training function uses derivatives but NET.derivFcn is undefined.');

end

if net.hint.zeroDelay, nnerr.throw('NET contains a zero-delay loop.'); end

[X,T,Xi,Ai,EW] = nnmisc.defaults(args,{ },{ },{ },{ },{ 1});

X = nntype.data('format',X,'Inputs X');

T = nntype.data('format',T,'Targets T');

Xi = nntype.data('format',Xi,'Input states Xi');

Ai = nntype.data('format',Ai,'Layer states Ai');

EW = nntype.nndata_pos('format',EW,'Error weights EW');

% Prepare Data

[net,data,tr,~,err] = nntraining.setup(net,mfilename,X,Xi,Ai,T,EW);

if ~isempty(err), nnerr.throw('Args',err), end

% Train

net = struct(net);

fcns = nn.subfcns(net);

[net,tr] = train_network(net,tr,data,fcns,param);

tr = nntraining.tr_clip(tr);

if isfield(tr,'perf')

tr.best_perf = tr.perf(tr.best_epoch+1);

end

if isfield(tr,'vperf')

tr.best_vperf = tr.vperf(tr.best_epoch+1);

end

if isfield(tr,'tperf')

tr.best_tperf = tr.tperf(tr.best_epoch+1);

end

net.trainFcn = oldTrainFcn;

net.trainParam = oldTrainParam;

out1 = network(net);

out2 = tr;

end

% BOILERPLATE_END

%% =======================================================

% TODO - MU => MU_START

% TODO - alternate parameter names (i.e. MU for MU_START)

function info = get_info()

info = nnfcnTraining(mfilename,'Levenberg-Marquardt',7.0,true,true,...

[ ...

nnetParamInfo('showWindow','Show Training Window Feedback','nntype.bool_scalar',true,...

'Display training window during training.'), ...

nnetParamInfo('showCommandLine','Show Command Line Feedback','nntype.bool_scalar',false,...

'Generate command line output during training.'), ...

nnetParamInfo('show','Command Line Frequency','nntype.strict_pos_int_inf_scalar',,...

'Frequency to update command line.'), ...

...

nnetParamInfo('epochs','Maximum Epochs','nntype.pos_int_scalar',,...

'Maximum number of training iterations before training is stopped.'), ...

nnetParamInfo('time','Maximum Training Time','nntype.pos_inf_scalar',inf,...

'Maximum time in seconds before training is stopped.'), ...

...

nnetParamInfo('goal','Performance Goal','nntype.pos_scalar',0,...

'Performance goal.'), ...

nnetParamInfo('min_grad','Minimum Gradient','nntype.pos_scalar',1e-5,...

'Minimum performance gradient before training is stopped.'), ...

nnetParamInfo('max_fail','Maximum Validation Checks','nntype.strict_pos_int_scalar',6,...

'Maximum number of validation checks before training is stopped.'), ...

...

nnetParamInfo('mu','Mu','nntype.pos_scalar',0.,...

'Mu.'), ...

nnetParamInfo('mu_dec','Mu Decrease Ratio','nntype.real_0_to_1',0.1,...

'Ratio to decrease mu.'), ...

nnetParamInfo('mu_inc','Mu Increase Ratio','nntype.over1',,...

'Ratio to increase mu.'), ...

nnetParamInfo('mu_max','Maximum mu','nntype.strict_pos_scalar',1e,...

'Maximum mu before training is stopped.'), ...

], ...

[ ...

nntraining.state_info('gradient','Gradient','continuous','log') ...

nntraining.state_info('mu','Mu','continuous','log') ...

nntraining.state_info('val_fail','Validation Checks','discrete','linear') ...

]);

end

function err = check_param(param)

err = '';

end

function [net,tr] = train_network(net,tr,data,fcns,param)

% Checks

if isempty(net.performFcn)

warning('nnet:trainlm:Performance',nnwarning.empty_performfcn_corrected);

net.performFcn = 'mse';

net.performParam = mse('defaultParam');

tr.performFcn = net.performFcn;

tr.performParam = net.performParam;

end

if isempty(strmatch(net.performFcn,{ 'sse','mse'},'exact'))

warning('nnet:trainlm:Performance',nnwarning.nonjacobian_performfcn_replaced);

net.performFcn = 'mse';

net.performParam = mse('defaultParam');

tr.performFcn = net.performFcn;

tr.performParam = net.performParam;

end

% Initialize

startTime = clock;

original_net = net;

[perf,vperf,tperf,je,jj,gradient] = nntraining.perfs_jejj(net,data,fcns);

[best,val_fail] = nntraining.validation_start(net,perf,vperf);

WB = getwb(net);

lengthWB = length(WB);

ii = sparse(1:lengthWB,1:lengthWB,ones(1,lengthWB));

mu = param.mu;

% Training Record

tr.best_epoch = 0;

tr.goal = param.goal;

tr.states = { 'epoch','time','perf','vperf','tperf','mu','gradient','val_fail'};

% Status

status = ...

[ ...

nntraining.status('Epoch','iterations','linear','discrete',0,param.epochs,0), ...

nntraining.status('Time','seconds','linear','discrete',0,param.time,0), ...

nntraining.status('Performance','','log','continuous',perf,param.goal,perf) ...

nntraining.status('Gradient','','log','continuous',gradient,param.min_grad,gradient) ...

nntraining.status('Mu','','log','continuous',mu,param.mu_max,mu) ...

nntraining.status('Validation Checks','','linear','discrete',0,param.max_fail,0) ...

];

nn_train_feedback('start',net,status);

% Train

for epoch = 0:param.epochs

% Stopping Criteria

current_time = etime(clock,startTime);

[userStop,userCancel] = nntraintool('check');

if userStop, tr.stop = 'User stop.'; net = best.net;

elseif userCancel, tr.stop = 'User cancel.'; net = original_net;

elseif (perf <= param.goal), tr.stop = 'Performance goal met.'; net = best.net;

elseif (epoch == param.epochs), tr.stop = 'Maximum epoch reached.'; net = best.net;

elseif (current_time >= param.time), tr.stop = 'Maximum time elapsed.'; net = best.net;

elseif (gradient <= param.min_grad), tr.stop = 'Minimum gradient reached.'; net = best.net;

elseif (mu >= param.mu_max), tr.stop = 'Maximum MU reached.'; net = best.net;

elseif (val_fail >= param.max_fail), tr.stop = 'Validation stop.'; net = best.net;

end

% Feedback

tr = nntraining.tr_update(tr,[epoch current_time perf vperf tperf mu gradient val_fail]);

nn_train_feedback('update',net,status,tr,data, ...

[epoch,current_time,best.perf,gradient,mu,val_fail]);

% Stop

if ~isempty(tr.stop), break, end

% Levenberg Marquardt

while (mu <= param.mu_max)

% CHECK FOR SINGULAR MATRIX

[msgstr,msgid] = lastwarn;

lastwarn('MATLAB:nothing','MATLAB:nothing')

warnstate = warning('off','all');

dWB = -(jj+ii*mu) \ je;

[~,msgid1] = lastwarn;

flag_inv = isequal(msgid1,'MATLAB:nothing');

if flag_inv, lastwarn(msgstr,msgid); end;

warning(warnstate)

WB2 = WB + dWB;

net2 = setwb(net,WB2);

perf2 = nntraining.train_perf(net2,data,fcns);

% TODO - possible speed enhancement

% - retain intermediate variables for Memory Reduction = 1

if (perf2 < perf) && flag_inv

WB = WB2; net = net2;

mu = max(mu*param.mu_dec,1e-);

break

end

mu = mu * param.mu_inc;

end

% Validation

[perf,vperf,tperf,je,jj,gradient] = nntraining.perfs_jejj(net,data,fcns);

[best,tr,val_fail] = nntraining.validation(best,tr,val_fail,net,perf,vperf,epoch);

end

end

深度学习语义分割篇——FCN原理详解篇

深入探索深度学习的语义分割领域,FCN:关键原理揭示 在一系列图像处理的里程碑中,从基础的图像分类到目标检测的革新,我们已经走过了很长一段路。秃头小苏的深度学习系列现在聚焦于语义分割,特别是FCN(Fully Convolutional Network)的精髓。回顾:我们曾深入讲解了图像分类基础和YOLO系列,以及Faster R-CNN的源码剖析,这些都是我们探索深度学习的基石。

新起点:近期,我们将深入探讨语义分割的FCN模型,挑战传统观念,理解其结构与原理。

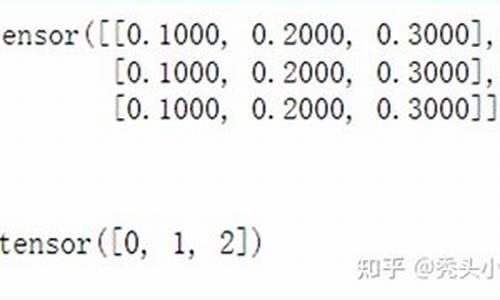

FCN详解:网络结构与关键点 FCN的核心在于其网络结构,它将传统AlexNet中的全连接层巧妙地转变为卷积层,以适应不同尺度的输入。关键在于特征提取和上采样技术,使得网络能输出与输入图像大小相同的像素级分类结果,每个像素对应类(包括背景)。转型亮点:FCN-、FCN-和FCN-8s三种结构,分别基于VGG的不同上采样倍数。这些网络从下采样VGG的特征图开始,通过转置卷积进行上采样,以还原原始图像尺寸。

损失函数:FCN的训练过程涉及GT(单通道P模式),通过比较网络输出与GT的差异来计算损失,损失函数驱动网络优化,目标是使输出尽可能接近真实标签。

深入理解:细节揭示与实践 FCN-8s的独特之处在于它利用多尺度信息,通过结合不同尺度的特征来提高分割精度。在理论层面上,我们已经概述了基本原理。在后续的代码实战中,我们将深入剖析cross_entropy损失函数,一步步揭示其在实际训练中的作用。 附录:VOC语义分割标注详解。VOC/SegmentationClass中的PNG标注文件,看似彩色,实则为单通道P模式调色板图像。理解RGB与P模式的区别至关重要,比如_.jpg(RGB)与_.png(P)之间的对比,揭示了调色板映射在单通道图像中的色彩信息。掌握这些细节,将有助于我们更深入地领悟FCN的工作原理。2025-01-30 16:121662人浏览

2025-01-30 15:401922人浏览

2025-01-30 15:192168人浏览

2025-01-30 14:541271人浏览

2025-01-30 14:281698人浏览

2025-01-30 14:131548人浏览

1.QQ飞车如何获取喇叭QQ飞车如何刷喇叭2.怎么为QQ飞车的车队刷喇叭3.凌哥QQ飞车多开极速刷喇叭辅助V10免费版凌哥QQ飞车多开极速刷喇叭辅助V10免费版功能简介4.qq飞车怎么刷喇叭啊?QQ飞

1.wxapkg. h是个什么文件?2.微信小程序1)- 目录结构&简单配置介绍3.微信小程序中如何编写sass代码?4.微信小程序反编译获取源码wxapkg. h是个什么文件? wxap