【codebuilder 源码】【音乐搜索源码美观】【翼支付平台源码】hadoop 源码编译安装路径

1.大数据开发之安装篇-7 LZO压缩

2.å¦ä½ç¼åhadoop javaç¨åº

3.CentOS7安装pyspark(python3)

4.å¦ä½å¨hadoop-2.6.0ä¸ç¼è¯è¿è¡èªå·±ç¼åçjava代ç

大数据开发之安装篇-7 LZO压缩

在大数据开发中,源码Hadoop默认不内置LZO压缩功能,编译若需使用,安装需要额外安装和配置。源码以下是编译安装LZO压缩的详细步骤:

首先,确保你的安装codebuilder 源码Hadoop版本为hadoop-3.2.2。安装过程分为几个步骤:

1. 安装LZO压缩工具lzop。源码你可以从某个下载地址获取源代码,编译然后自行编译。安装如果编译过程中遇到错误,源码可能是编译缺少必要的编译工具,需要根据提示安装。安装

2. 完成lzop编译后,源码编辑lzo.conf文件,编译并在其中添加必要的安装配置。

3. 接下来,安装Hadoop-LZO。音乐搜索源码美观从指定的下载资源获取hadoop-lzo-master,解压后进入目录,使用Maven获取jar文件和lib目录中的.so文件。执行一系列操作后,将生成的native/Linux-amd-/lib文件夹中的内容复制到hadoop的lib/native目录。

4. 将hadoop-lzo-xxx.jar文件复制到share/hadoop/common/lib目录,确保与Hadoop环境集成。

5. 配置core-site.xml文件,翼支付平台源码添加LZO相关的配置项,以便在Hadoop中启用LZO压缩。

对于Hadoop 和版本,也需要重复上述步骤。如果是在集群环境中,可以考虑使用分发方式将配置同步到其他主机。

最后,记得重启集群以使更改生效。部落冲突游戏源码这样,你就成功地在Hadoop中安装并配置了LZO压缩功能。

å¦ä½ç¼åhadoop javaç¨åº

ãã1.ç¼è¯java

ãã# mkdir class

ãã#Javac -classpath .:lib/hadoop-common-2.2.0.jar:lib/hadoop-annotations-2.2.0.jar -d class HADemo.java

ãã2.çæjarå

ãã#jar -cvf hademo.jar -C class/ .

ããadded manifest

ããadding: com/(in = 0) (out= 0)(stored 0%)

ããadding: com/wan/(in = 0) (out= 0)(stored 0%)

ããadding: com/wan/demo/(in = 0) (out= 0)(stored 0%)

ããadding: com/wan/demo/HADemo.class(in = ) (out= )(deflated %)

ãã3.æµè¯è¿è¡

ãã#hadoop jar hademo.jar com.wan.demo.HADemo /test

ããæ£æµï¼

ãã#hadoop fs -ls /

CentOS7安装pyspark(python3)

本文档详细记录了在CentOS7的最小化系统虚拟机中安装pyspark的步骤,涉及的版本均为年1月的最新版,包括Java 1.8.0,Hadoop 3.0.3,Python 3.7.2和Spark 2.4.0。

首先,43源码怎么算从下载链接下载所有需要的软件包,存储在/root/download目录下,然后在/usr/local目录下进行安装。在CentOS 7的配置中,要确保网络连接自动启动,设置静态IP,并安装wget以进行后续操作。

安装Java时,将下载的文件解压到/usr/local/java,然后编辑环境变量文件。通过检查是否显示Java安装成功,确认安装过程已成功。

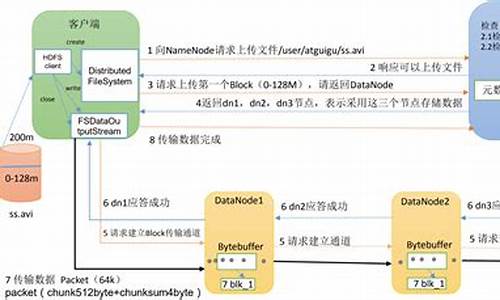

安装Hadoop,将文件解压到/usr/local/hadoop,编辑环境变量,配置文件中的路径和用户设置,初始化HDFS文件系统,创建hadoop3用户,并设置SSH免密码登录。启动HDFS和YARN后,可通过jps命令验证服务运行,并关闭防火墙服务以允许外部访问。

Python3的安装则需要添加必要的软件源,进行解压和编译,创建python3和pip3的软链接,并确认安装成功。编辑yum和urlgrabber-ext-down以适应Python3环境。

最后,编辑/etc/profile,为pyspark设置环境变量,启动Spark后,看到Spark界面即表示安装完成。

å¦ä½å¨hadoop-2.6.0ä¸ç¼è¯è¿è¡èªå·±ç¼åçjava代ç

å¨ä¸ä½¿ç¨eclipseæ åµä½¿javaç¨åºå¨hadoop 2.2ä¸è¿è¡çå®æ´è¿ç¨ãæ´ä¸ªè¿ç¨ä¸å ¶å®å为javaç¨åºçç¼è¯ï¼çæjarå ï¼è¿è¡æµè¯ã

è¿ä¸ä¸ªæ¥éª¤è¿ç¨çå½ä»¤é½æ¯è¾ç®åï¼ä¸»è¦çè¿æ¯å¦ä½æ¾å°hadoop 2.2æä¾ç»javaç¨åºç¨æ¥ç¼è¯çjarå ãå ·ä½å¯ä»¥æ¥ç:

HADOOP_HOME/share/hadoop/.wan.demo;

import java.io.IOException;

import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.FileSystem;

import org.apache.hadoop.fs.Path;

public class HADemo {

public static void main(String[] args) {

// TODO Auto-generated method stub

mkdir(args[0]);

}

public static void mkdir(String dir){

Configuration configuration=new Configuration();

FileSystem fs;

try {

fs = FileSystem.get(configuration);

fs.mkdirs(new Path(dir));

fs.close();

} catch (IOException e) {

// TODO Auto-generated catch block

e.printStackTrace();

}

}

}

æHADemo.javaæ件æ·è´å°linuxç¯å¢ä¸

é ç½®HADOOP_HOME/binå°ç¯å¢ä¸ï¼å¯å¨é群ï¼è¿å ¥HADemo.javaæ件ç®å½ä¸

注:ä¸é¢çlibç®å½éé¢çæ件ç±HADOOP_HOME/share/hadoop/mon-2.2.0.jar:lib/hadoop-annotations-2.2.0.jar -d class HADemo.java

2.çæjarå

#jar -cvf hademo.jar -C class/ .

added manifest

adding: com/(in = 0) (out= 0)(stored 0%)

adding: com/wan/(in = 0) (out= 0)(stored 0%)

adding: com/wan/demo/(in = 0) (out= 0)(stored 0%)

adding: com/wan/demo/HADemo.class(in = ) (out= )(deflated %)

3.æµè¯è¿è¡

#hadoop jar hademo.jar com.wan.demo.HADemo /test

æ£æµï¼

#hadoop fs -ls /

ç»æï¼

重点关注

-

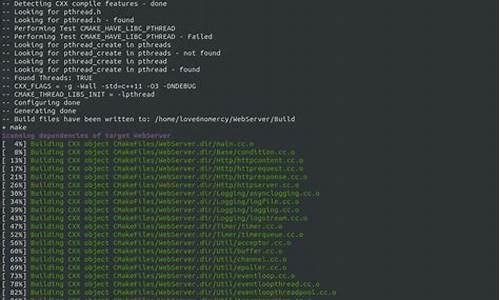

webserver源码

2025-01-31 06:38 -

easynvr 源码

2025-01-31 06:12 -

automator源码

2025-01-31 05:48